业内人士近日对 OpenAI 今年 3 月发布的 GPT-4 大模型进行了大揭秘,其中包括 GPT-4 模型架构、训练和推理的基础设施、参数量、训练数据集、token 数、成本、混合专家模型 (Mixture of Experts, MoE) 等非常具体的参数和信息。

文章作者之一正是此前爆料谷歌内部文件《我们没有护城河,OpenAI也没有》的 Dylan Patel。

下面介绍一下这篇揭秘 GPT-4 技术细节文章的主要内容。

文章开头就指出,OpenAI 之所以不 Open,不是为了保护人类不被 AI 毁灭,而是因为他们构建的大模型是可复制的,未来中国和美国的互联网大厂(比如谷歌、Meta、腾讯、百度、字节跳动),以及 AI 头部初创企业,都会有能力构建出可以媲美 GPT-4 甚至超越 GPT-4 的大模型。

而 OpenAI 最持久的护城河,就在于他们拥有真实用户的使用反馈、业内最顶尖的工程人才,以及先发优势带来的领先地位。

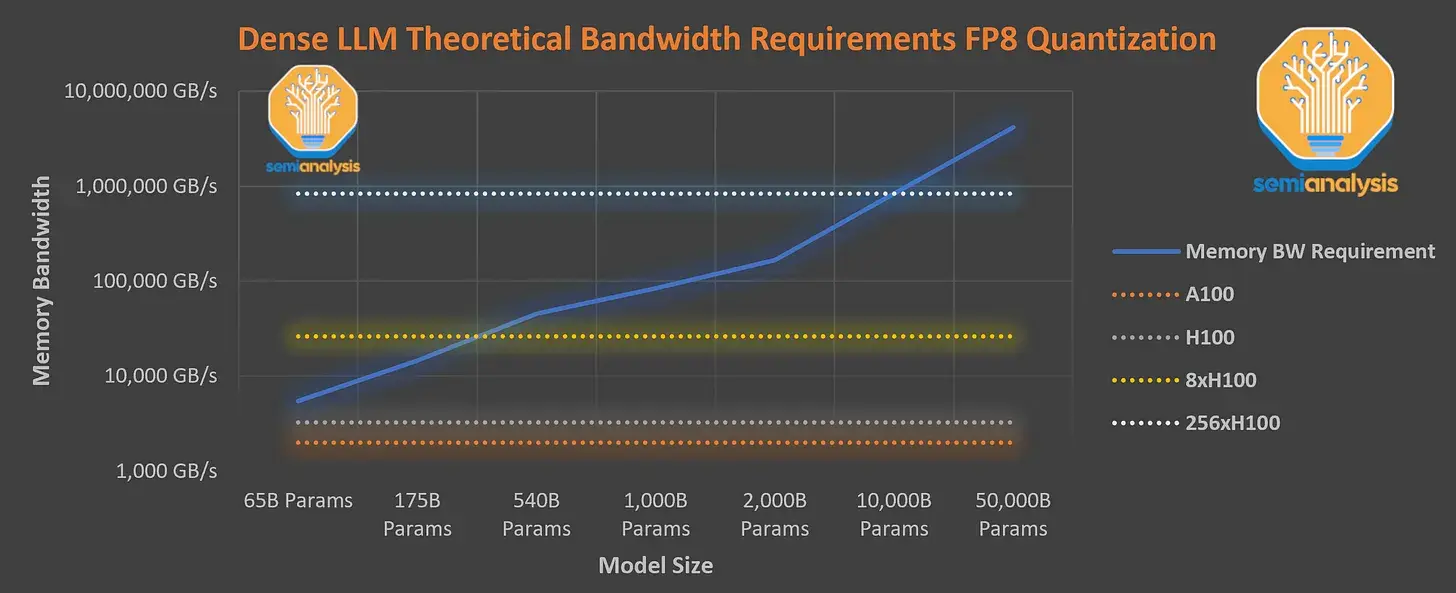

据介绍,GPT-4 在 120 层中总共包含了 1.8 万亿参数,而 GPT-3 只有约 1750 亿个参数。而为了保持合理的成本,OpenAI 采用 MoE 模型来进行构建。

具体而言,GPT-4 使用了 16 个混合专家模型 (mixture of experts),每个有 1110 亿个参数,每次前向传递路由经过两个专家模型。

此外,它有 550 亿个共享注意力参数,使用了包含 13 万亿 tokens 的数据集训练,tokens 不是唯一的,根据迭代次数计算为更多的 tokens。

GPT-4 预训练阶段的上下文长度为 8k,32k 版本是对 8k 微调的结果。如果是在云端进行训练,以 每 A100 小时 1 美元计算,那么一次的训练成本就高达 6300 万美元。不过今天的训练成本能降至 2150 万美元。

详情。