继今年7月在2023世界人工智能大会发起成立“大模型语料数据联盟”(以下简称“语料数据联盟”),上海人工智能实验室(上海AI实验室)于8月14日宣布,联合中央广播电视总台、人民网、国家气象中心、中国科学技术信息研究所、上海报业集团、上海文广集团等语料数据联盟成员,共同开源发布“书生·万卷” 1.0多模态预训练语料。

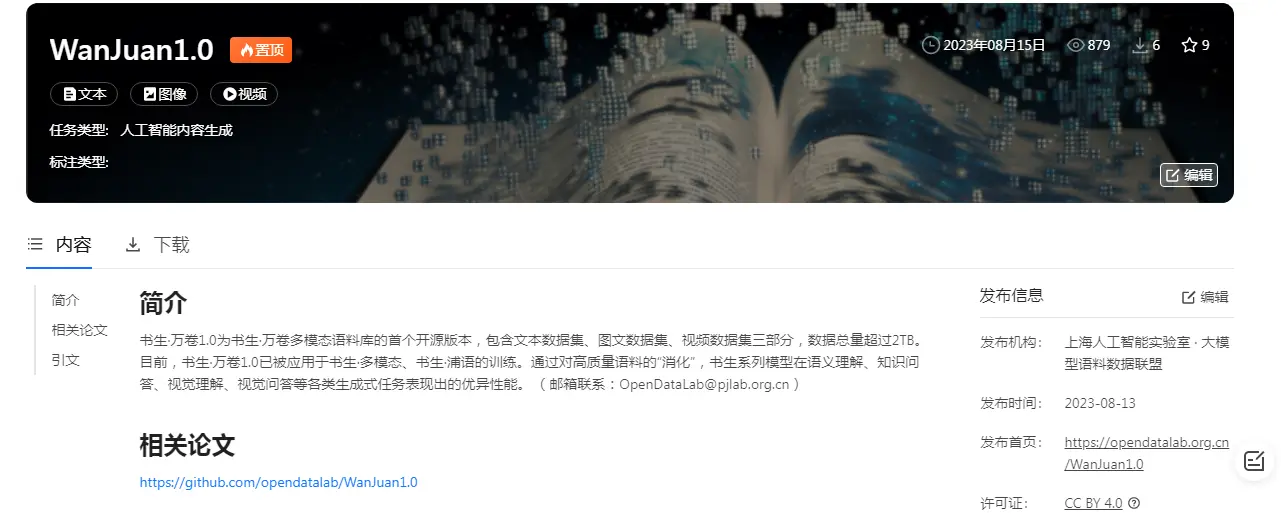

“书生·万卷” 1.0目前包含文本数据集、图文数据集、视频数据集三部分,本次开源的数据总量超过2TB。集合语料数据联盟成员丰富的内容积累与上海AI实验室领先的数据处理能力等优势,“书生·万卷”将为学术界及产业界提供更符合主流中文价值对齐的高质量大模型多模态预训练语料。

“书生·万卷”链接:https://opendatalab.org.cn/WanJuan1.0

今年7月6日,上海AI实验室正式发布全新升级的“书生通用大模型体系”,包括书生·多模态大模型、书生·浦语语言大模型和书生·天际实景三维大模型等三大基础模型,并且推出了书生·浦语开源体系(https://github.com/InternLM/InternLM),它不仅开放了一个高质量的语言大模型 InternLM-7B,在多项主流评测中性能领先于Llama-2-7B,还提供了覆盖从数据、训练到评测的全链条开放体系。书生·浦语开源体系为企业提供免费商用许可,降低大模型应用门槛,全面赋能产业。

“书生·万卷”已被用于书生大模型预训练,其开源发布将进一步降低大模型技术探索和落地的门槛。

据了解,“书生·万卷”的主要构建团队——OpenDataLab旨在建设面向人工智能开发者的超大规模、高质量、多模态开放数据服务平台,致力于打造国内公开数据资源的基础建设。目前,该平台已建立共享的多模态数据集5500个,涵盖超过1万亿token文本语料、60亿张图像、8亿个视频片段和100万个3D模型。