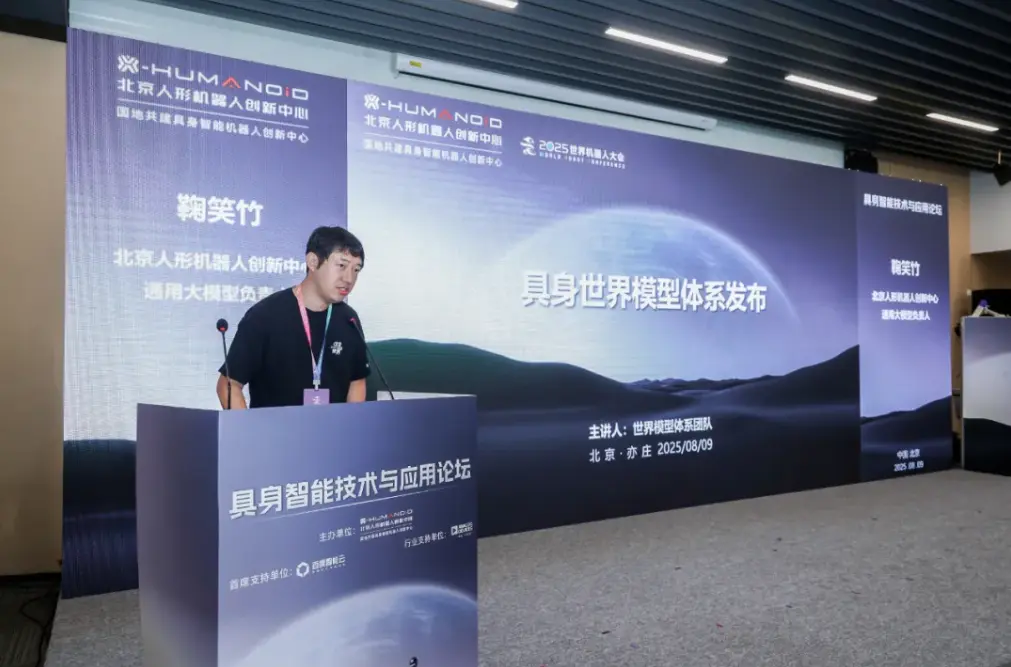

北京人形宣布发布了四项具身智能核心成果,包括:具身世界模型体系,打通认知与预判能力;跨本体VLA模型,实现跨本体、多场景、多技能的通用性;人形机器人全身控制自主导航系统,解决移动与操作协同的执行瓶颈;以及千台机器人真实场景数据采集计划,为持续进化提供规模化数据燃料。

其中,“具身世界模型体系”旨在为机器人理解现实与预测变化提供核心大脑。这一体系包含具备物理时空理解与推理能力的72B具身多模态大模型以及实现神经网络驱动世界模拟器的具身智能世界基座模型。

针对通用大模型具身场景下精细空间/几何理解不足,物理交互误差大等问题,北京人形基于千问72B多模态大模型,通过自研数据清洗与混合模态训练框架,实现行业首个长视频理解72B具身多模态大模型PelicanVLM,在现代多模态系统超长视频语言理解评测集Egoschema、李飞飞的视觉空间智能基准评测集VSI-Bench,多模态大模型物理推理能力大规模基准测试集PhyX等6项具身相关公开评测集上超越GPT-4o、Gemini flash 2.0以及原模型,7个公开评测基准平均性能超过SOTA 11%。

基于超过5000小时视频数据训练的具身世界模型WU,则为具身智能机器人提供了“看见未来”的眼睛,并以未见场景下的泛化能力,解锁具身无限数据的可能性。

“跨本体VLA模型”成为通用性和扩展性的关键支撑。北京人形正式发布跨本体VLA模型 XR-1,让同一模型实现跨本体运行、多场景适配、多技能调用。在业界充分验证的 RoboMIND 高质量具身数据基础上,XR-1 通过积累超百万量级的自有多本体数据,采用首创的多模态视动统一表征学习,有效利用各类机器人操作数据和海量互联网视频数据。

在此基础上,XR-1 利用多模态视动统一表征训练、跨本体主网络训练和特定场景微调三阶段训练范式,实现机器人跨本体的通用操作知识积累和特定场景的多任务快速学习。在多种机器人本体上大量真实环境测试,实证了该方法的多本体、多技能、多任务、稳健泛化能力,以及其在快速掌握新技能上的巨大潜力。以 XR-1 为基础,“慧思开物”能够快速构建面向各类场景任务的通用技能库,实现多本体、多场景、多任务的能力,显著减少具身智能应用开发的成本与用时。

“人形机器人全身控制自主导航系统”聚焦机器人在实际工作中的核心能力,由“自主导航系统”和“全身控制系统”组成。自主导航系统具备点对点导航、动态障碍感知和自主避障能力,并搭载OCC环视感知模块,实现对环境的实时占用与语义感知,拓展了自主与语义导航的应用空间。

全身控制系统支持机器人在移动和站立状态下灵活进行上身动作控制,涵盖预设动作、遥操作与自主操作开发。通过稳定的质心控制与精准的末端控制,保障操作任务的稳定高效执行。

“千台机器人真实场景数据采集计划”是业内首个千台级规模的真实场景数据采集计划,通过搭建远程遥操作中心,让千台机器人走出实验室,深入工厂车间、物流仓储、酒店商超等真实工业场景,在执行实际作业任务的同时,持续采集多模态交互数据。