英伟达开源了 NVIDIA Llama Nemotron 中最大尺寸的推理模型 Llama-3.1-Nemotron-Ultra-253B-v1,可用于聊天机器人开发、AI Agent 工作流、检索增强生成(RAG)和代码生成等场景。

根据英伟达开放模型许可证及 Llama 3.1 社区许可协议,该模型已获准用于商业用途。

NVIDIA Llama Nemotron 是英伟达在上个月推出的一系列支持推理和多样化 Agent 任务的模型。该模型系列提供三种不同尺寸:

- Nano:8B,基于Llama 3.1 8B进行微调,适用于在个人电脑和边缘设备上实现最高精度。

- Super:49B,从Llama 3.3 70B蒸馏而来,适用于在数据中心GPU上实现最高精度和最高吞吐量。

- Ultra:253B,从Llama 3.1 405B蒸馏而来,适用于在多GPU数据中心服务器上实现最大智能代理精度。

当时英伟达只放出了 Nano 和 Super 两个模型版本,现在他们终于把最大的版本 Ultra 给开源了。

目前,该模型的代码已在 Hugging Face 平台上公开,包含开放的权重和训练后数据。

- 模型地址:https://huggingface.co/nvidia/Llama-3_1-Nemotron-Ultra-253B-v1

- 文档地址:https://docs.api.nvidia.com/nim/reference/nvidia-llama-3_1-nemotron-ultra-253b-v1

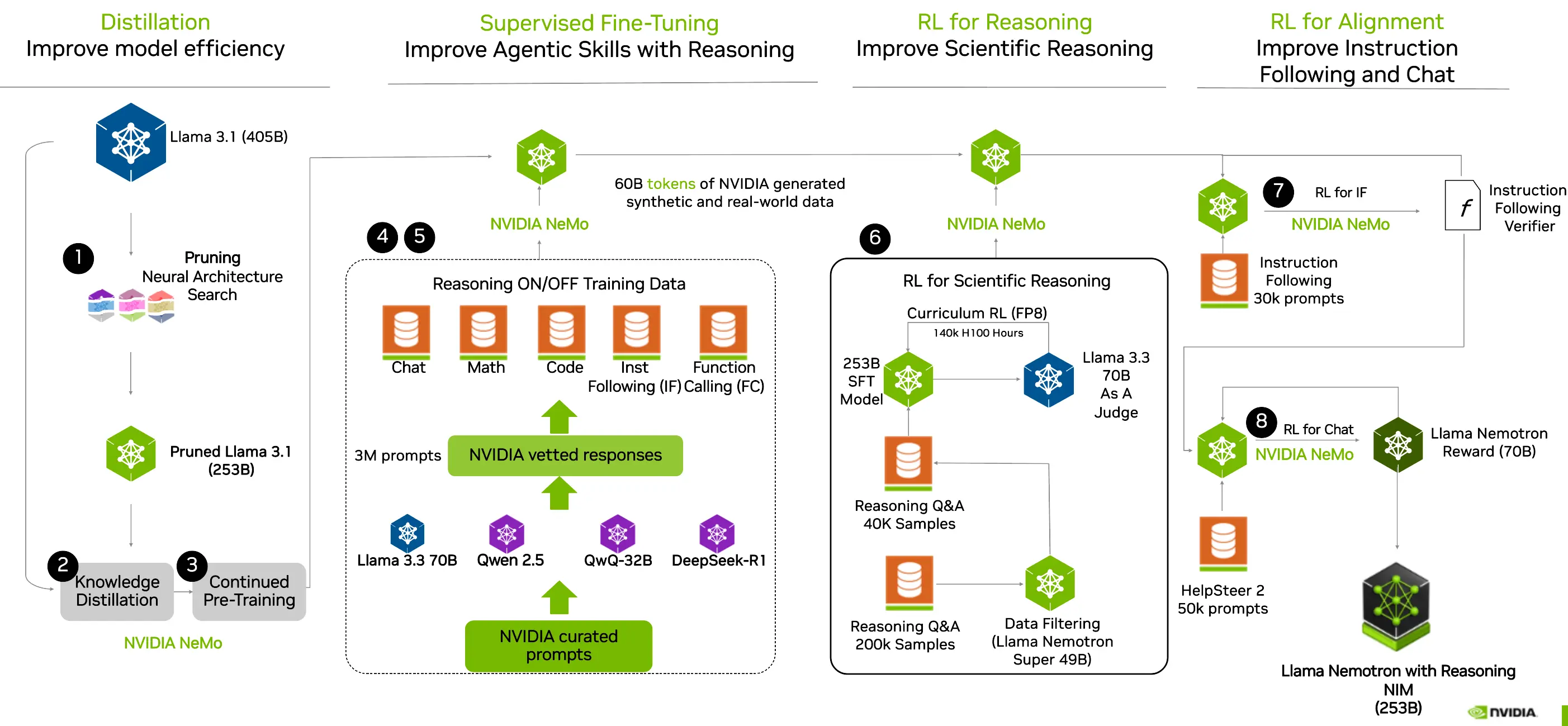

Llama-3.1-Nemotron-Ultra-253B-v1 是从 Meta Llama-3.1-405B-Instruct 蒸馏得到的。这是一个经过后训练的推理模型,专注于推理、人类聊天偏好以及诸如 RAG(检索增强生成)和工具调用等任务。该模型支持 128K 的上下文长度,并且可以在单个 8xH100 节点上进行推理。

据介绍,Llama-3.1-Nemotron-Ultra-253B 的设计目标是支持高级推理、指令遵循以及 AI 助手工作流程。技术特点如下:

- 采用神经架构搜索(NAS)优化架构

- 引入跳跃注意力层、融合前馈网络(FFN)和可变 FFN 压缩率

- 降低内存占用和计算需求,保持输出质量

- 可在单个 8x H100 GPU 节点高效部署

- 部署支持 B100 和 Hopper 微架构硬件

- 在 BF16 和 FP8 精度模式下均验证通过

Llama-3.1-Nemotron-Ultra-253B-v1 的训练包括模型蒸馏、SFT、面向推理的 RL 以及面向对齐的 RL 四个阶段。

特别地,区别于一些只支持推理的大模型,Ultra 模型支持通过系统提示词控制是否开启推理模式。

该模型基于 Meta 早期的 Llama-3.1-405B-Instruct 模型开发,拥有 2530 亿个参数,在多项第三方基准测试中表现出色:

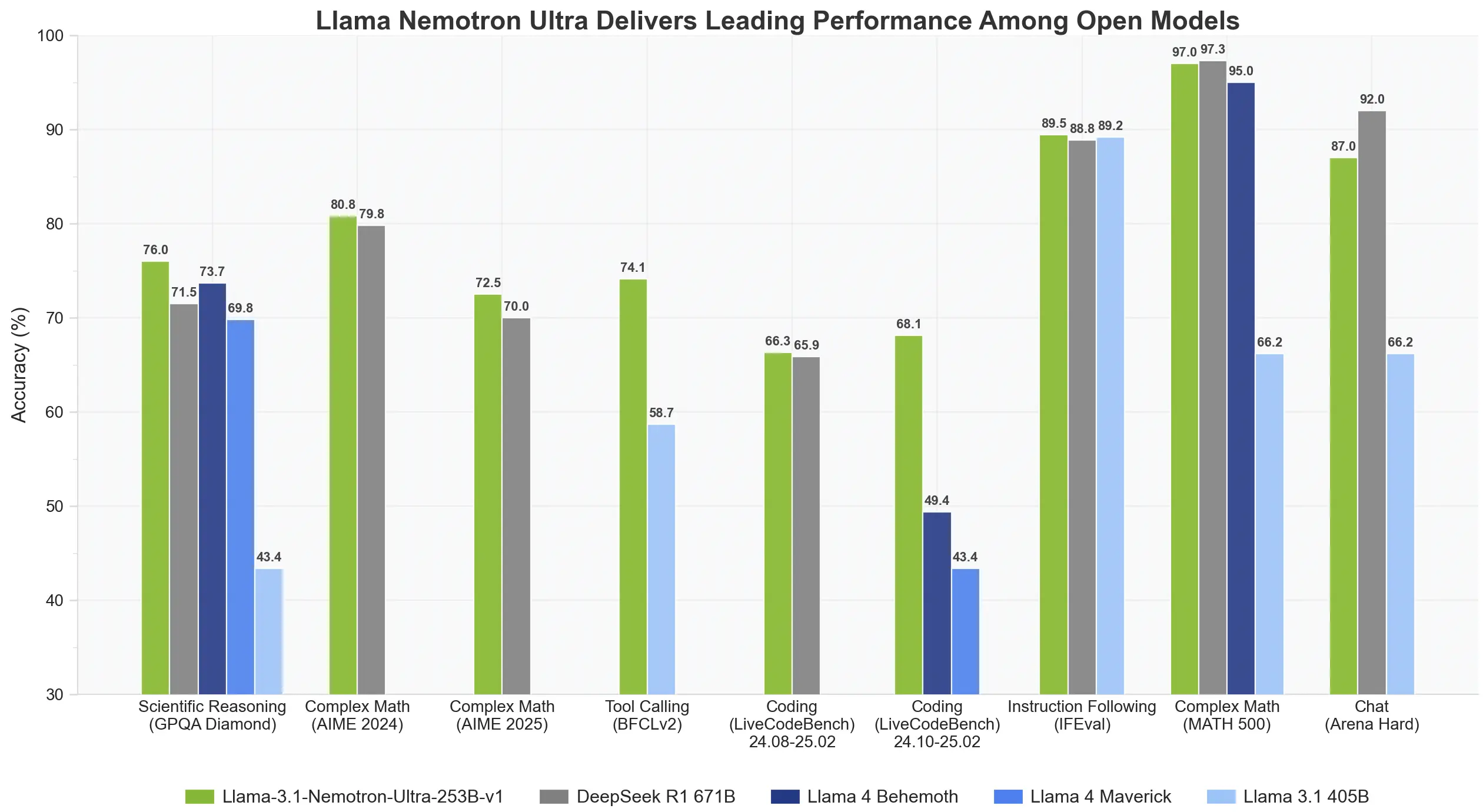

- 值得关注的是,英伟达新模型的性能逼近拥有 6710 亿参数的 DeepSeek R1,但只用了不到一半的参数量。

- 测试结果显示,GPQA(76 vs. 71.5)、IFEval 指令遵循(89.5 vs. 88.8)和 LiveCodeBench 编码任务(66.3 vs. 65.9)。并且,Llama-3.1-Nemotron-Ultra-253B 推理吞吐量也比 DeepSeek R1 671B 高 4 倍。

- 但在 MATH500 和 Arena Hard 基准测试中,DeepSeek R1 仍略占优势。

- 在一系列基准测试中,Llama-3.1-Nemotron-Ultra-253B-v1 优于 Meta 最新发布的 Llama 4 Behemoth 和 Llama 4 Maverick。