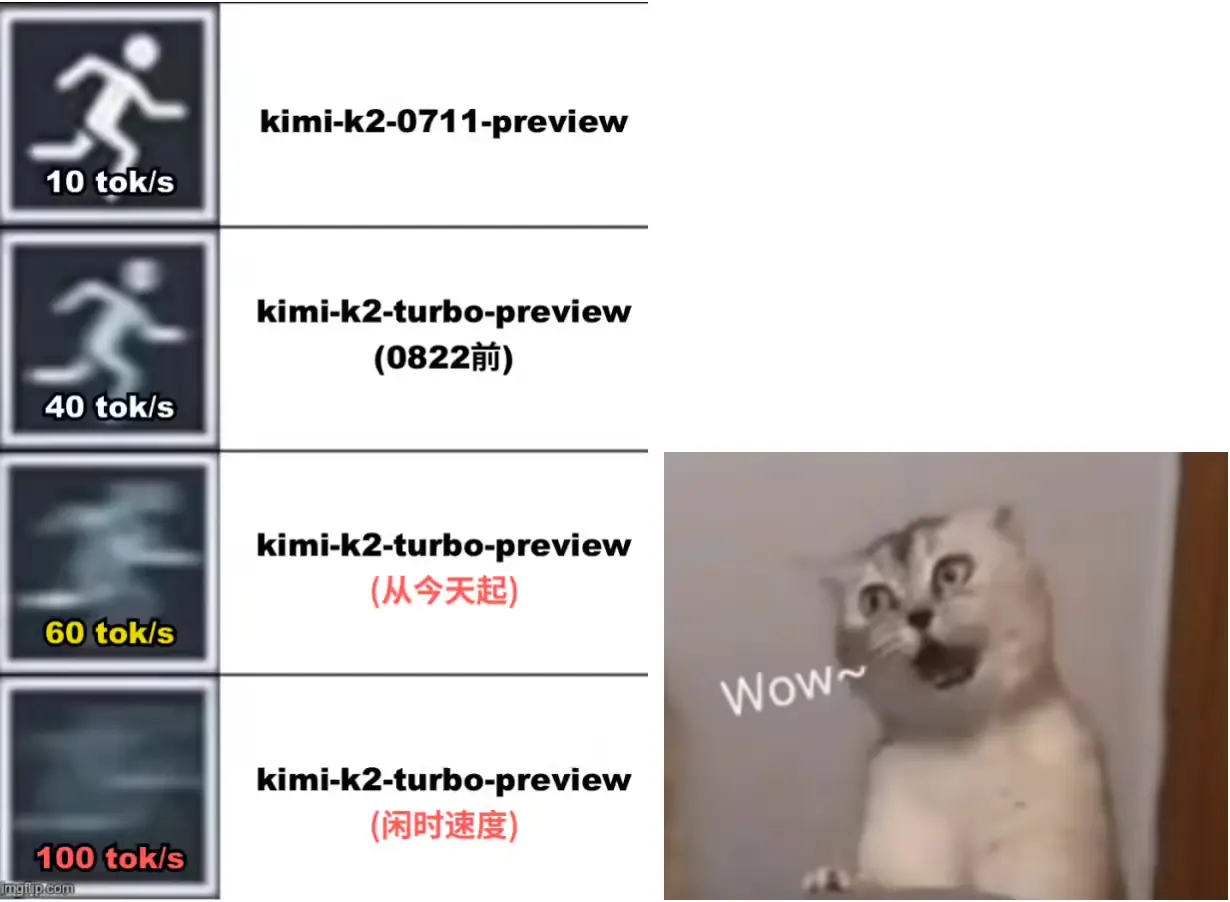

月之暗面今日宣布,经过工程师们的不懈努力,kimi-k2-turbo-preview 模型输出速度已经提升至每秒 60 Tokens,最高可达每秒 100 Tokens。

目前该模型仍然享受 5 折特惠价格,模型每百万 tokens 输入价格(缓存命中)¥2.00,输入价格(缓存未命中)¥8.00,输出价格 ¥32.00。9 月 1 日恢复原价。

更多信息请访问官网 https://platform.moonshot.cn

月之暗面 8 月 1 日发布 Kimi K2 高速版 —— Kimi-K2-turbo-preview,模型参数与 Kimi-K2 一致,但输出速度由每秒 10 Tokens 提升至每秒 40 Tokens。

Kimi K2 是一款具备更强代码能力、更擅长通用 Agent 任务的 MoE 架构基础模型,总参数 1T,激活参数 32B。