DeepSeek 宣布启用上下文硬盘缓存技术,把预计未来会重复使用的内容,缓存在分布式的硬盘阵列中。如果输入存在重复,则重复的部分只需要从缓存读取,无需计算。该技术不仅降低服务的延迟,还大幅削减最终的使用成本。

缓存命中的部分,DeepSeek 费用为 0.1元 每百万 tokens。至此,大模型的价格再降低一个数量级。

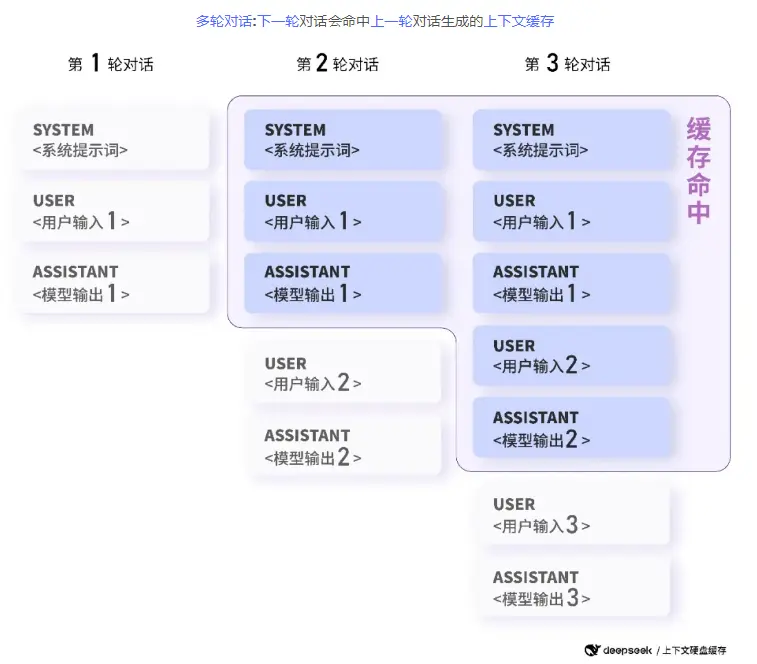

目前,硬盘缓存服务已经全面上线,用户无需修改代码,无需更换接口,硬盘缓存服务将自动运行,系统自动按照实际命中情况计费。只有当两个请求的前缀内容相同时(从第 0 个 token 开始相同),才算重复。中间开始的重复不能被缓存命中。

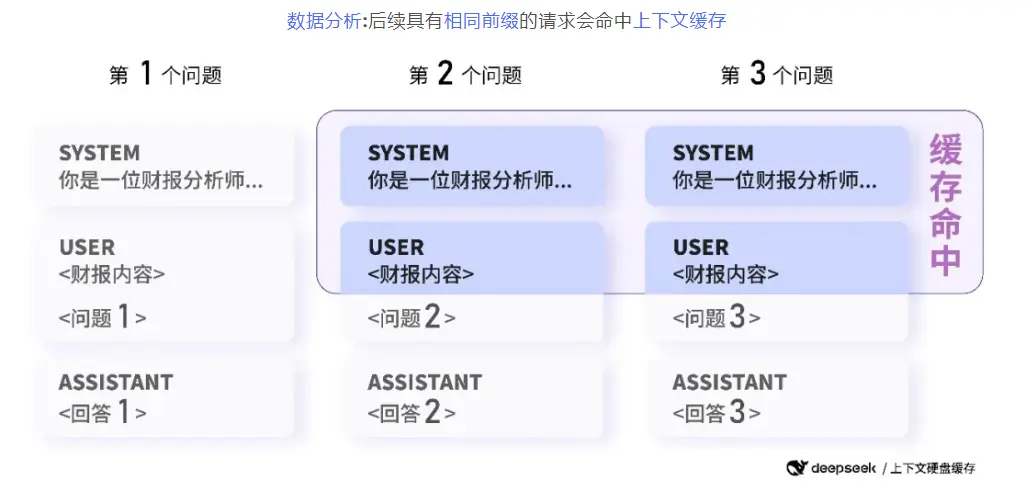

两个经典场景的缓存举例:

多种应用能从上下文硬盘缓存中受益:

- 具有长预设提示词的问答助手类应用

- 具有长角色设定与多轮对话的角色扮演类应用

- 针对固定文本集合进行频繁询问的数据分析类应用

- 代码仓库级别的代码分析与排障工具

公告指出,该技术最高可以节省 90% 的费用(需要针对缓存特性进行优化)。即使不做任何优化,按历史使用情况,用户整体节省的费用也超过 50%。缓存没有其它额外的费用,只有0.1 元每百万 tokens。缓存占用存储无需付费。

该缓存系统在设计的时候已充分考虑了各种潜在的安全问题。每个用户的缓存是独立的,逻辑上相互不可见,从底层确保用户数据的安全和隐私。长时间不用的缓存会自动清空,不会长期保留,且不会用于其他用途。