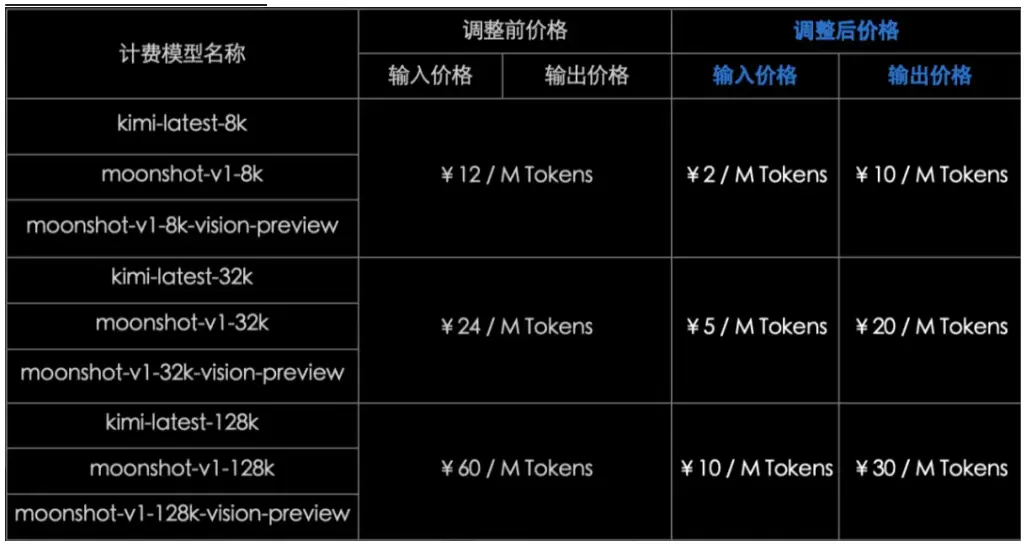

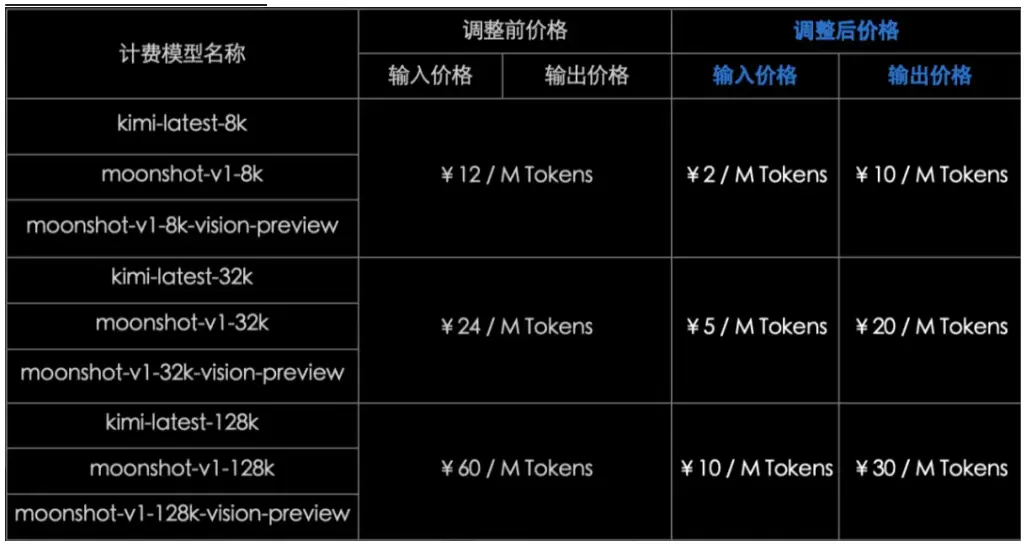

Kimi 开放平台官方公众号发文宣布,基于Moonshot AI一年来的技术积累和性能优化,已经在北京时间2025年4月7日0点对Kimi开放平台提供的模型推理服务进行价格调整,具体调整方案如图所示:

注:kimi-latest 模型自动缓存后的价格仍为 ¥1 / M Tokens。

上下文缓存的价格调整方案如下:

更多详情可查看:

- 模型推理产品定价

- 上下文缓存产品定价

Kimi 开放平台官方公众号发文宣布,基于Moonshot AI一年来的技术积累和性能优化,已经在北京时间2025年4月7日0点对Kimi开放平台提供的模型推理服务进行价格调整,具体调整方案如图所示:

注:kimi-latest 模型自动缓存后的价格仍为 ¥1 / M Tokens。

上下文缓存的价格调整方案如下:

更多详情可查看:

」。 官方介绍,Kimi K2 总参数达到 1T,激活参数为 32B,上下文长度为 128k,并且支持 ToolCalls、JSON Mode、Partial Mode、联网搜索功能等;但模型不支持视觉功能。 具体来看,Kimi K2 现已具备稳定的复杂指令解析能力,可将需求

国初创公司 Moonshot AI 的开源大语言模型 Kimi K2在 OpenRouter 平台的 token 消耗量(市场份额指标)上迅速攀升,超越 xAI 的 Grok4和 OpenAI 的 GPT-4.1,成为近期 AI 领域的焦点。 OpenRouter 作为一个统一 API 平台,允许开发者访问包括 Kimi K

今日宣布,经过工程师们的不懈努力,kimi-k2-turbo-preview 模型输出速度已经提升至每秒 60 Tokens,最高可达每秒 100 Tokens。 目前该模型仍然享受 5 折特惠价格,模型每百万 tokens 输入价格(缓存命中)¥2.00,输入价格(缓存未

话时,思考内容(或称推理过程)不需要放入请求模型的上下文中。我们通过如下例子说明如何正确使用 kimi-thinking-preview 进行多轮对话: import os import openai client = openai.Client( base_url="https://api.moonshot.cn/v1", api_key=os.getenv("MOONSHOT

在已有功能的增强或扩展上表现出色,能很好地理解上下文并延续逻辑 对于全新功能(无现成示例参考)的任务,需要更多上下文引导 始终保持与原项目一致的代码风格与架构模式,具备良好的工程一致性 Qwen-3 Cod

续我们也将继续根据域名成本的变化,及时合理地调整(下调 / 上涨)域名价格,并始终为您提供高品质的专业服务!您的满意是我们的动力,感谢您的理解与支持! 据了解,阿里云已于今年 4 月 1 日对部分小众域名价格进

DeepSeek 宣布启用上下文硬盘缓存技术,把预计未来会重复使用的内容,缓存在分布式的硬盘阵列中。如果输入存在重复,则重复的部分只需要从缓存读取,无需计算。该技术不仅降低服务的延迟,还大幅削减最终的使用成本。

味着月之暗面正式开启B端业务。 Kimi API 从今年 2 月开始开放给企业和开发者使用。在此期间,很多企业有了规模化的落地,对稳定性和数据安全提出了更高的要求。 本次发布的 Kimi 企业级 API 主要是在数据安全保障、并发速

想陪你聊天,更想帮你做事。 像现在的 K 线图功能,是模型自动调用外部工具生成的结果。我们正在逐步支持更多工具生态,让 Kimi 不止是对话的助手,更是具备行动力的智能体。 (我们也偷偷藏了一点点「人味儿」:App 点

doubao-seed-1.6:All-in-One 的综合模型,是国内首个支持256K 上下文的思考模型,支持深度思考、多模态理解、图形界面操作等多项能力。支持选择开启或关闭深度思考、自适应思考三种方式,其中自适应思考模式可根据提示词难度

速度慢的情况。 月之暗面表示,主要问题是访问量大 +模型体积大。月之暗面正在全力优化推理效率,也在加卡加机器。预计这几天内速度会有明显提升。同时,Kimi K2是完全开源的,大家也可以通过其他模型供应商接入使用

Kimi-K2 和 Qwen3-Coder 这两个模型是最近在编程任务上表现不错的开源模型,关于二者的比较可阅读这篇文章:Kimi K2 和 Qwen-3 Coder 在编程任务的详细对比。 Kimi K2 是一个最先进的混合专家 (MoE) 语言模型,激活参数为 320 亿,

研发代号为 “Sonic”。这是一个文本推理模型,支持256k上下文窗口。 类型 价格 输入 每 100 万 tokens 收费 $0.20 缓存输入 每 100 万 tokens 收费 $0.02 输出 每 100 万 tokens 收费 $1.50 该模型现已

,如果D = 4,PT可将同步开销减少87.5%。 为支持更长的上下文输入,我们设计了一种交错注意力架构,结合滑动窗口局部注意力层、旋转位置嵌入(RoPE)和无位置嵌入(NoPE)的全局注意力层。这种设置提高了长度泛化能力,减