微软发布了一款专为受限环境设计、参数量仅为3.8B的轻量级开源模型Phi-4-mini-flash-reasoning,其在数学推理任务上表现出色,且吞吐量大幅提升。

Phi-4-mini-flash-reasoning专为在内存和计算资源受限的环境下执行高强度、多步骤的数学推理任务而设计。该模型采用了混合SambaY架构,结合了差分注意力、状态空间模型(SSM)和分组查询注意力(GQA),并支持64K的上下文长度。

Phi-4-mini-flash-reasoning的训练数据完全由更强大的推理模型Deepseek-R1生成的合成数学内容构成,旨在从更强的模型中提炼知识。

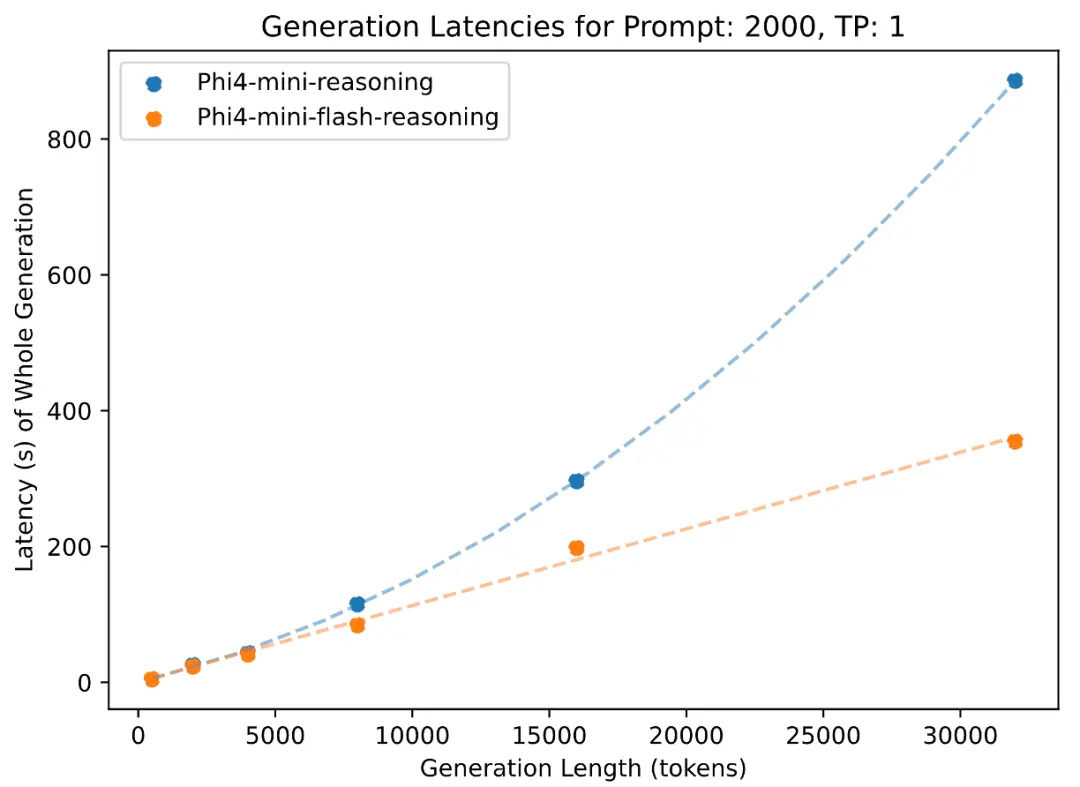

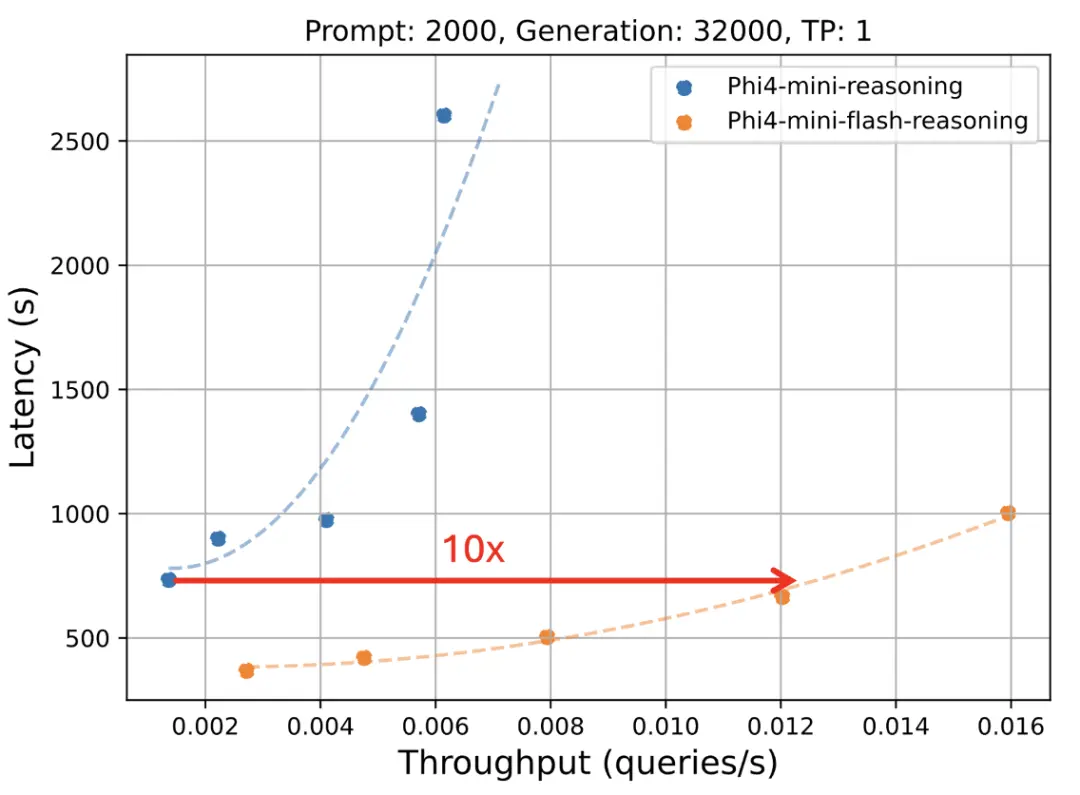

在AIME、Math500和GPQA Diamond等多个数学推理基准测试中,Phi-4-mini-flash-reasoning的表现与许多参数量远大于它的模型相当。与Phi-4-mini-reasoning相比,新模型在处理长序列生成任务时,吞吐量提升高达10倍,且延迟增长接近线性。

该模型已在Hugging Face上以MIT许可证发布,并可在Azure AI Foundry中使用。

https://huggingface.co/microsoft/Phi-4-mini-flash-reasoning

https://azure.microsoft.com/en-us/blog/reasoning-reimagined-introducing-phi-4-mini-flash-reasoning/

https://aka.ms/flashreasoning-paper

https://github.com/microsoft/PhiCookBook