微软开源了三个新版Phi-4小参数模型,分别是Reasoning、Min-Reasoning和Reasoning-plus。

Phi-4-Reasoning的基础架构源自微软开源的Phi-4 模型,为了提升其推理能力,微软通过监督微调和强化学习相结合的训练方法行了深度强化。

该方法的核心在于,先通过监督微调让大模型学习高质量的推理演示数据,从而生成详细的推理链,并能够有效地利用推理时的计算资源。优点类似于给模型提供了一个“标准答案”,让模型知道如何正确地进行推理。

Reasoning是基于Phi-4开发而成,mini版本适用于平板、手机等移动设备,而plus是强化学习版本,针对数学等特定领域进行了强化训练。

这三款模型的最大亮点之一便是算力消耗非常低,可以直接在消费级硬件环境上运行,以普通的 Windows 11设备为例,无论是CPU还是GPU,都能轻松实现本地部署。同时微软已经将Phi-4系列模型深度融入Windows系统生态,使其成为Copilot+PC的重要组成部分。

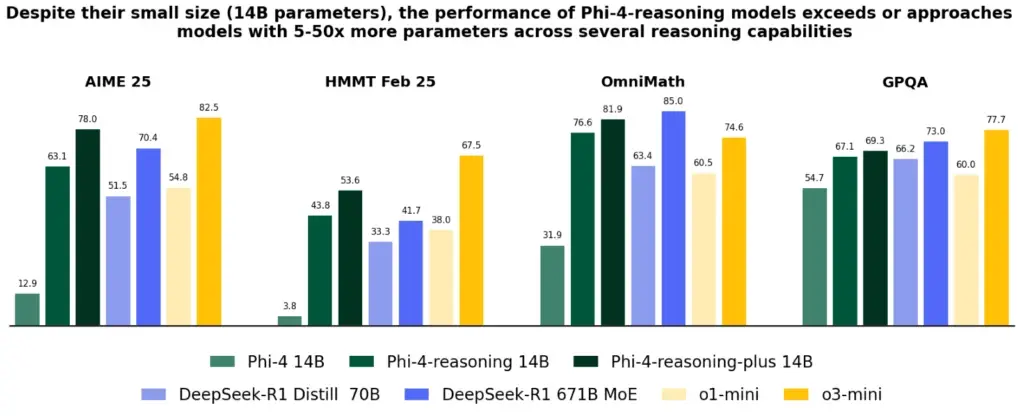

根据测试数据显示,Phi-4-Reasoning-plus版本只有140亿参数,但与DeepSeek开源的R1 6710亿参数相比性能几乎差不多,例如,在美国数学奥林匹克竞赛资格赛2025中,Reasoning-plus得分为78,R1为70.4;

哈佛-麻省理工数学竞赛Reasoning-plus为53.6,R1为41.7;Ominimath的测试中,Reasoning-plus为81.9,R1为85;GPQA中Reasoning-plus为69.3,R1为73,成为目前最强的开源小参数模型。

开源地址:

https://huggingface.co/microsoft/Phi-4-reasoning

https://huggingface.co/microsoft/Phi-4-mini-reasoning

https://huggingface.co/microsoft/Phi-4-reasoning-plus