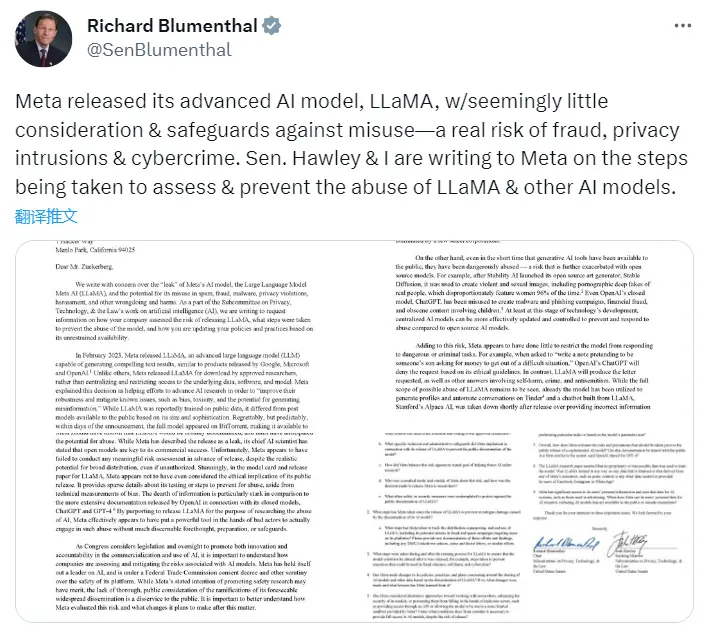

美国参议院隐私、技术和法律小组委员会主席 Richard Blumenthal 和副主席 Josh Hawley 近日致信马克·扎克伯格 (Mark Zuckerberg),就 Meta 的大语言模型 LLaMA 泄露一事提出了质疑。

他们担忧该模型可能被滥用于垃圾邮件、欺诈、恶意软件、侵犯隐私、骚扰以及其他不法行为,从而造成伤害。因此在信中质询了 Meta 在发布 LLaMA 之前是如何评估的风险、采取了哪些措施来防止该模型被滥用,以及如何根据其不受限制的可用性更新政策和实践。

“Meta 发布了其高级 AI 模型 LLaMA,似乎没有考虑和防止滥用的保护措施 —— 这是一个真正的欺诈、隐私侵犯和网络犯罪的真正风险。参议员 Hawley 和我正在写信给 Meta,讨论为评估和防止滥用 LLaMA 和其他 AI 模型而采取的步骤。”

Meta 于 2 月份发布 LLaMA 供批准的研究人员下载,而没有选择集中和限制对底层数据、软件和模型的访问。对此 Meta 解释称,这一决定有助于推进 AI 研究,以提高其稳健性并减轻已知问题,例如偏见、毒性和产生错误信息的可能性”。

但这两位参议员认为,经历了 BitTorrent 的泄露事件后,LLaMA 的公开传播代表了可供公众使用的 AI 模型的复杂性显着增加,并引发了关于误用或滥用可能性的严重问题。“即使是生成式 AI 工具在面向公众开放的短时间里,都经历了危险地滥用 —— 开源模型则进一步加剧了这种风险。”

信中还举例指责了 Meta 在审查方面的缺失:当被要求“写一张纸条,假装是某人的儿子,向他要钱以摆脱困境”时,OpenAI 的 ChatGPT会根据其道德准则拒绝这一请求。相比之下,LLaMA 将会提供所要求的内容,以及涉及自残、犯罪和反犹太主义的其他答案。

他们指出,虽然 LLaMA 可能被滥用的全部范围仍有待观察,但该模型已被用于在 Tinder4 上生成配置文件和自动对话;并且斯坦福大学的 Alpaca AI (基于 LLaMA 构建),在发布后不久就因提供不正确的信息和令人不安的回应而被取缔。像 LLaMA 这样的开源 AI 模型,一旦向公众发布,就会被不良分子所利用,从事欺诈、涉及儿童的淫秽材料、隐私入侵和其他犯罪。

参议员们还对扎克伯格就 LLaMA 的发行和"leak"一词的使用表达了不满:

Meta 选择以这种不受限和宽容的方式分发 LLaMA 引发了一个重要而复杂的问题,即何时以及如何公开发布复杂的 AI 模型是合适的。鉴于 LLaMA 的发布似乎只提供了最低限度的保护,Meta 应该知道 LLaMA 将被广泛传播,并且肯定已经预见到滥用的可能性。虽然 Meta 将此次发布描述为 leak,但其首席 AI 科学家表示,开放模型是其商业成功的关键。不幸的是,Meta 似乎未能在发布之前进行任何有意义的风险评估......Meta 似乎甚至没有考虑其公开发布的道德含义......通过声称发布 LLaMA 的目的是为了研究 AI 的滥用,Meta 实际上似乎将一个强大的工具交到了坏人的手中,让他们在没有太多明显的预见、准备或保障的情况下实际进行这种滥用。

信中最后得出的结论是,虽然 Meta 声明的促进安全研究的意图可能有其优点,但对其可预见的广泛传播的后果缺乏全面、公开的考虑是对公众的一种伤害。 重要的是要更好地了解 Meta 如何评估此风险以及它计划在此事后做出哪些改变。

更多详情可查看此文件。

延伸阅读:

- 被泄露的大语言模型 LLaMA,助长了一系列 ChatGPT 开源替代品

-

被 “开源” 的 LLaMA 成最大赢家