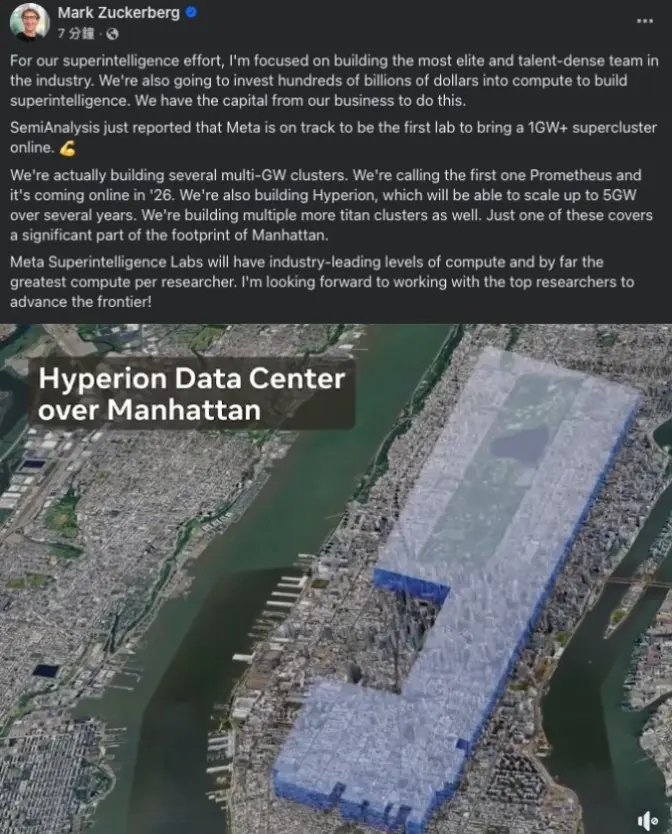

Meta 首席执行官马克·扎克伯格通过社交媒体宣布,公司正加速推进人工智能基础设施建设,计划上线全球首个功耗超过1吉瓦(GW)的超级计算机集群“Prometheus”,预计于2026年投入使用。同时,Meta 正在规划另一个名为“Hyperion”的超大规模集群,未来几年内功耗将达到5GW,规模堪比曼哈顿。

Meta 的“Prometheus”超级计算机集群被定位为全球首个功耗超过1吉瓦的 AI 算力基础设施。这一集群将搭载约130万块 NVIDIA H100GPU,预计提供超过2艾克萨(exaflops)的混合精度算力,远超 Meta 此前于2022年推出的 AI Research SuperCluster(RSC,约5exaflops)。

Prometheus 专为训练下一代大语言模型(如 Llama4)及通用人工智能(AGI)设计,目标是支持多模态 AI 任务,包括实时语音翻译、增强现实(AR)应用及元宇宙相关技术。

与传统超级计算机不同,Prometheus 采用 NVIDIA Quantum2InfiniBand 网络架构和 Grand Teton 硬件平台(Meta 贡献给开放计算项目 OCP 的设计),优化了 GPU 间的通信效率和数据中心能效。社交媒体上,开发者对 Prometheus 的规模表示震撼,称其“重新定义了 AI 算力的上限”。

除了 Prometheus,Meta 还透露正在规划“Hyperion”集群,预计功耗高达5GW,规模堪比一座小型城市。这一集群将进一步扩展 Meta 的 AI 基础设施,目标是支持更复杂的模型训练和推理任务。

有分析指出,Hyperion 的能耗相当于 xAI 30 万张 GPU 集群的 20 倍。xAI 近期宣布其 Memphis 超级计算机集群(约30万块 GPU)功耗在200-300兆瓦,而微软与 OpenAI 合作的 Stargate 项目计划投资超5000亿美元建设 AI 数据中心。

Hyperion 的具体细节尚未完全公开,但 Meta 表示,该集群将采用液冷技术和高性能网络架构,以应对大规模 AI 训练的散热和通信需求。此外,Meta 计划在2025年投资600-650亿美元用于数据中心建设和 AI 团队扩张,以确保算力与人才储备的同步增长。

Meta 强调,Prometheus 和 Hyperion 将延续其在开放计算(Open Compute Project)和 PyTorch 等开源生态中的承诺。集群设计基于 Grand Teton 平台,支持 RoCE 和 InfiniBand 两种网络架构,展示了 Meta 在硬件灵活性和可扩展性上的探索。

此外,Meta 承诺在数据隐私方面采取严格措施,集群将与互联网隔离,数据传输全程加密,以保护用户数据安全。

开发者对 Meta 的开源策略表示欢迎,认为这将进一步降低 AI 开发门槛。然而,也有用户指出,如此大规模的算力部署可能需要更透明的能源使用和碳排放报告,以回应公众对可持续性的关注。