日前,由清华博士曹越创立的 Sand.AI,公布了一款名为「Magi-1」的自回归视频生成模型,其主打两个能力:

- 无限长度扩展:通过前一段生成的内容进行后一段视频的制作,从而实现跨时间的无缝连贯叙事;

- 生成时长控制精准到每一秒。

而从公布的数据显示,具体性能测试结果如下:

- Physics-IQ(对多种物理定律的理解)基准测试:Magi-1 获得 56.02% 的高分成绩,超越可灵 1.6、Sora 等一众模型;

- 人类评估:与海螺、腾讯混元、通义万相 Wan2.1 相比,Magi-1 在指令跟随和运动质量等方面更具优势,但与可灵 1.6 在视觉质量存在差距;

- VBench-I2V 基准:Magi-1(2 倍解码器)以 89.28 的高分排名第一,在动态程度(Dynamic Degree)上有较大优势。

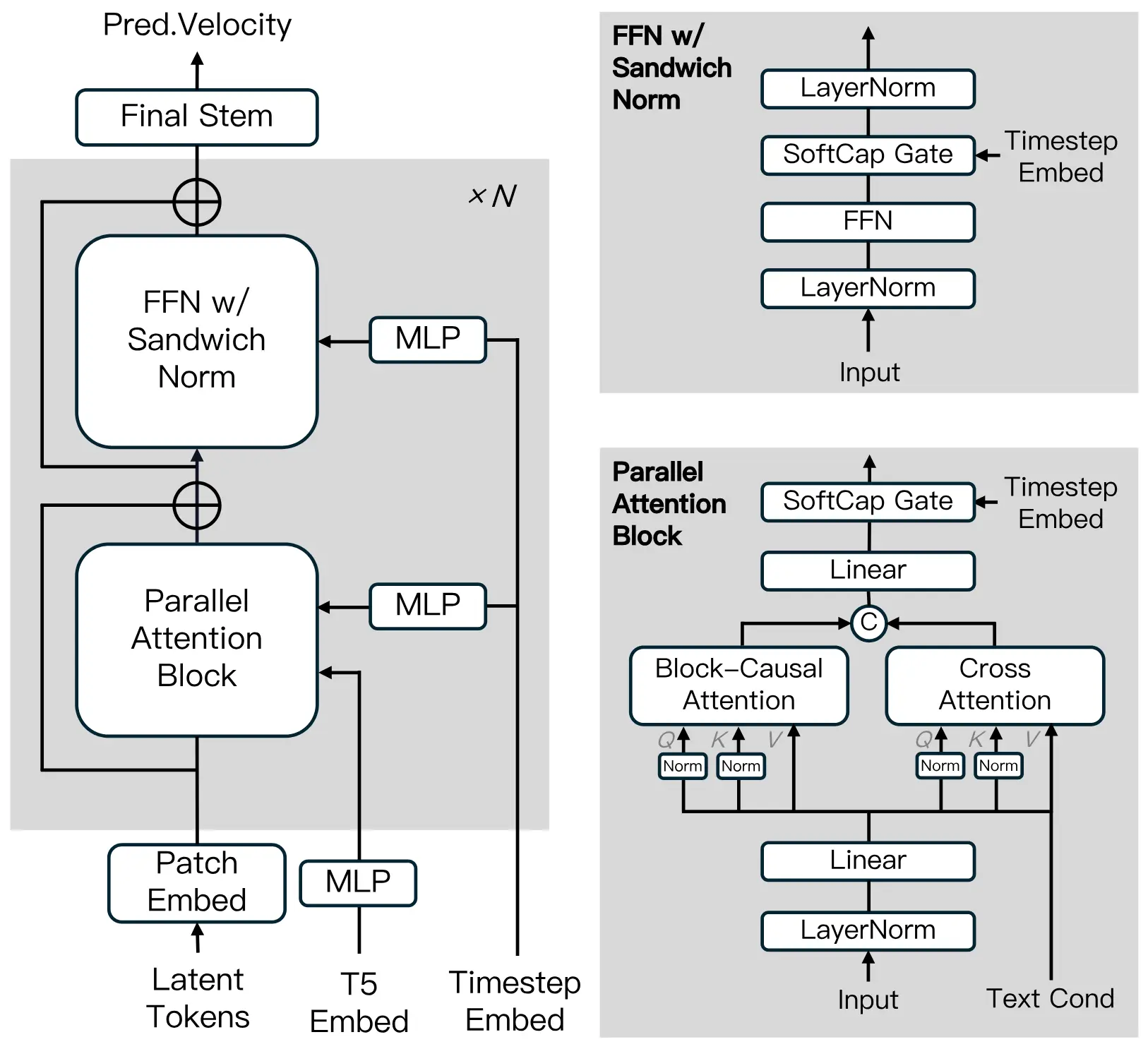

技术上,Magi-1 整体架构基于 Diffusion Transformer,采用 Flow-Matching 作为训练目标。

值得一提的是,据公布的信息显示,Magi-1 通过自回归去噪方式预测固定长度的视频片段,提高了视频生成效率和前后因果性(保证前后内容生成逻辑一致)。

目前,Magi-1 已上架 Sand.AI 官网(可以免费体验!),并且模型权重、代码也进行 100% 开源,技术报告也进行全面公布。

而背后的 Sand.AI 创始人为曹越,其博士毕业于清华大学软件学院,并于 2018 年获清华大学特等奖学金。曹越于 2022 年创办 AGI 公司「光年之外」,后加入智源研究院领导多模态与视觉研究中心。随后在 2023 年,曹越创立了 Sand.AI,并很长一段时间与其他成员保持「隐身」状态。

团队成员方面,有不少与曹越有着类似的历程:智源研究院实习、光年之外创始成员、微软亚洲研究院实习等等。另据了解,San.AI 已完成三轮融资,主要参与方包括今日资本、经纬创投等。

- 体验链接:https://sand.ai/

- GitHub:https://github.com/SandAI-org/Magi-1

- HuggingFace:https://huggingface.co/sand-ai/MAGI-1