Intel近日宣布,其专为本地生成式AI设计的AI Playground软件正式开源,为Intel Arc GPU用户提供了一个强大的AI模型运行平台。AI Playground支持多种图像、视频生成模型以及大型语言模型(LLMs),通过优化本地计算资源,显著降低了AI应用的硬件门槛。

核心功能:多模态AI模型一站式支持

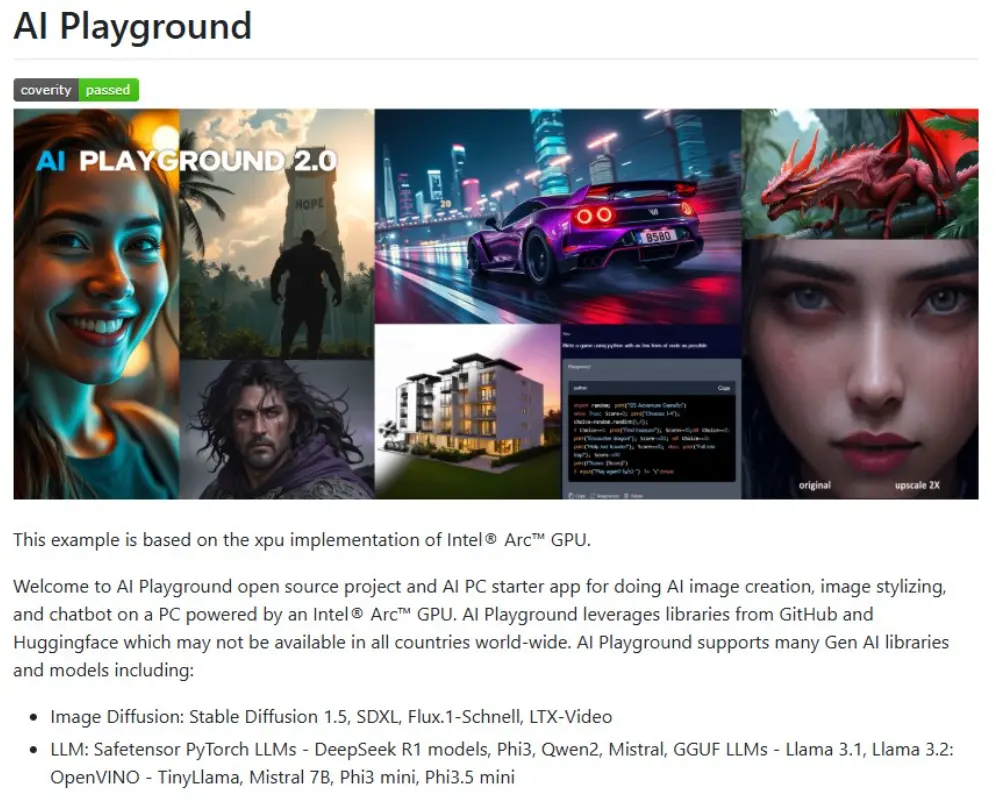

- AI Playground作为一款用户友好的“AI中心”,集成了丰富的生成式AI功能,涵盖图像生成、图像风格化、文本生成与聊天机器人等场景。AIbase梳理了其支持的模型与功能:

- 图像与视频生成:支持Stable Diffusion1.5、SDXL、Flux.1-Schnell和LTX-Video模型,可实现文本到图像、图像风格化以及文本到视频生成,生成结果在分辨率与细节上表现出色。

- 大型语言模型:兼容Safetensor PyTorch格式的DeepSeek R1、Phi3、Qwen2、Mistral,以及GGUF格式的Llama3.1、Llama3.2,结合OpenVINO优化的TinyLlama、Mistral7B、Phi3mini和Phi3.5mini,提供高效的本地聊天与推理能力。

- ComfyUI工作流:通过集成ComfyUI,AI Playground支持高级图像生成工作流,如Line to Photo HD与Face Swap,提升创作灵活性。

AI Playground不直接附带模型,用户需从Hugging Face或CivitAI下载模型并放置于指定文件夹,平台提供直观的模型加载界面,确保操作简便。

技术架构:OpenVINO优化本地性能

AI Playground基于Intel的OpenVINO框架,针对Arc GPU与Core Ultra处理器进行了深度优化。AIbase分析,其关键技术包括:

- OpenVINO加速:为聊天与图像生成提供高效推理支持,显著提升低vRAM设备(如8GB Arc GPU)的性能。

- Llama.cpp与GGUF支持:实验性后端扩展了GGUF模型的兼容性,预填充模型列表简化用户配置。

- 模块化设计:通过Add Model功能,用户可直接输入Hugging Face模型ID或本地路径,灵活加载自定义模型。

硬件要求方面,AI Playground支持Intel Core Ultra-H/V处理器或Arc A/B系列GPU(最低8GB vRAM)。尽管为开源Beta版,Intel提供了详细的故障排查指南,确保用户快速上手。低vRAM设备在运行SDXL等高分辨率模型时可能速度较慢,建议优先使用Flux.1-Schnell等轻量化模型。