昆仑万维宣布继续开源第二代奖励模型(Reward Model)Skywork-Reward-V2系列,共包含8个基于不同基座模型和不同大小的奖励模型,参数规模从6亿到80亿不等,其在七大主流奖励模型评测榜单中全面夺魁。在2024年9月,昆仑万维曾首次开源了Skywork-Reward系列模型及相关数据集。

公告称,在打造这一新一代奖励模型的过程中,昆仑万维方面构建了一个包含总共4000万对偏好对比的混合数据集Skywork-SynPref-40M。

为实现大规模、高效的数据筛选与过滤,特别设计了人机协同的两阶段流程,将人工标注的高质量与模型的规模化处理能力相结合。在这一流程中,人类提供经过严格验证的高质量标注,大型语言模型(LLMs)则根据人工指导进行自动整理和扩充。

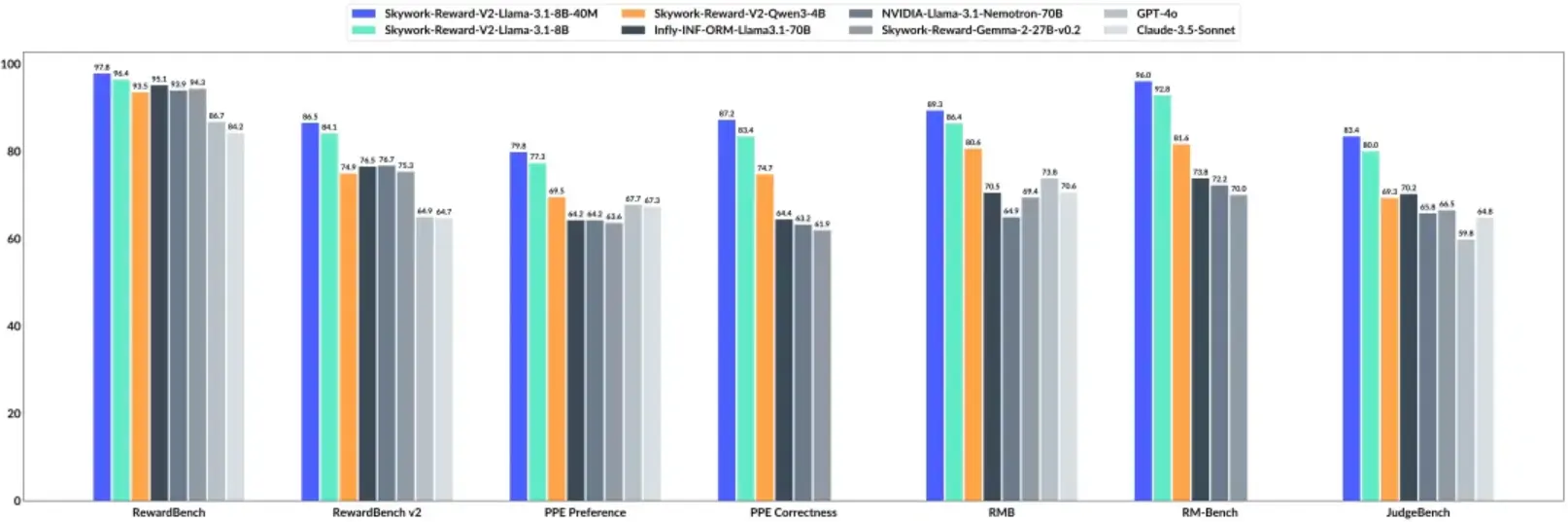

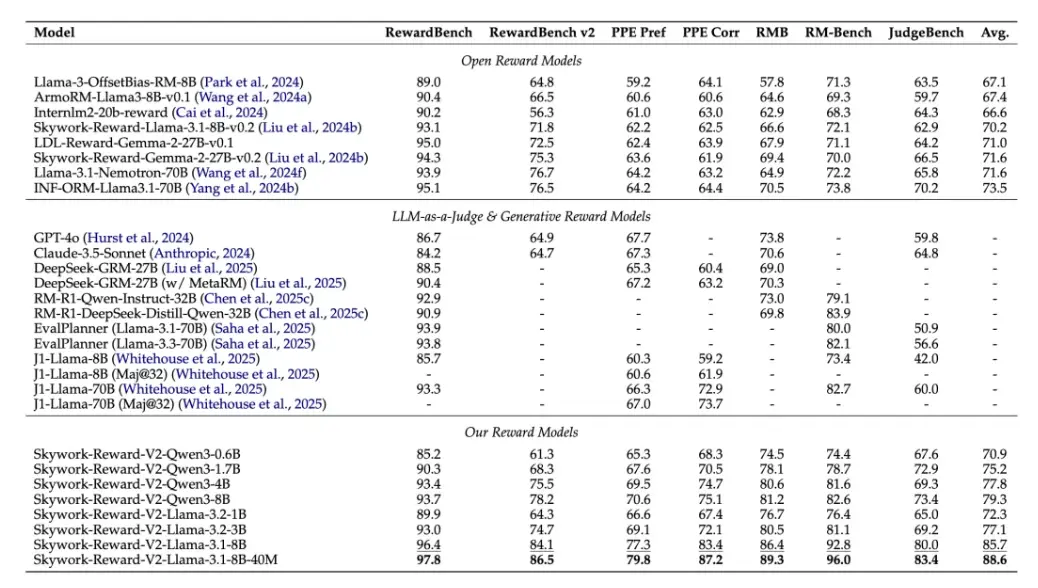

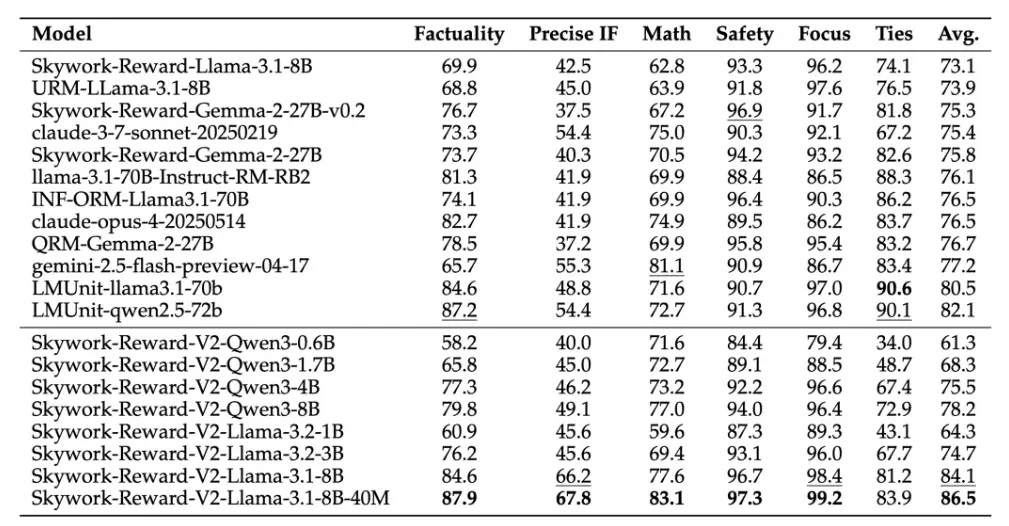

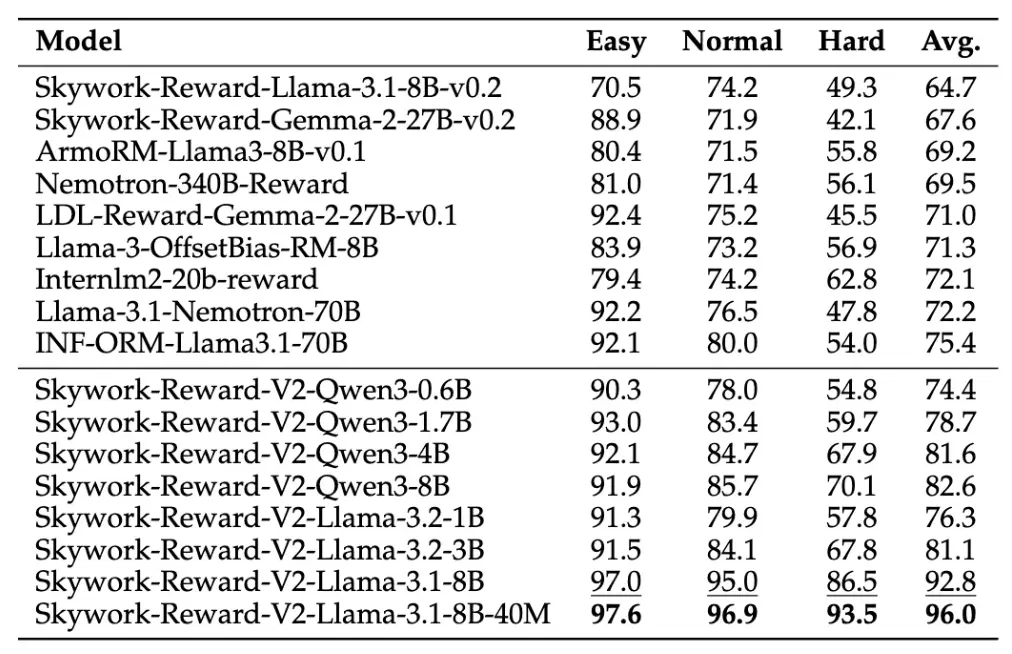

基于上述优质的混合偏好数据开发了Skywork-Reward-V2系列,其展现了广泛的适用性,在多个能力维度上表现出色,包括对人类偏好的通用对齐、客观正确性、安全性、风格偏差的抵抗能力,以及best-of-N扩展能力。经实验验证,该系列模型在七个主流奖励模型评测基准上均获得最佳表现。

相比上一代Skywork-Reward,昆仑万维全新发布的Skywork-Reward-V2系列提供了基于Qwen3和LLaMA3系列模型训练的8个奖励模型,参数规模覆盖从6亿至80亿。

即便基于最小模型Skywork-Reward-V2-Qwen3-0.6B,其整体性能已几乎达到上一代最强模型Skywork-Reward-Gemma-2-27B-v0.2的平均水平。更进一步,Skywork-Reward-V2-Qwen3-1.7B在平均性能上已超越当前开源奖励模型的SOTA——INF-ORM-Llama3.1-70B。而最大规模的Skywork-Reward-V2-Llama-3.1-8B。

此外,Skywork-Reward-V2在多项高级能力评估中均取得领先成绩:包括Best-of-N(BoN)任务、偏见抵抗能力测试(RM-Bench)、复杂指令理解及真实性判断(RewardBench v2),展现了出色的泛化能力与实用性。

Skywork-Reward-V2系列模型专注于对偏好数据规模扩展的研究,昆仑万维方面表示,其团队也将研究辐射面陆续转向其他尚未被充分探索的领域,例如替代训练技术与建模目标。

更多详情可查看官方公告。