字节跳动 Seed 团队发布并开源了多模态基础模型BAGEL,该模型拥有70亿个活跃参数,总参数量达140亿。

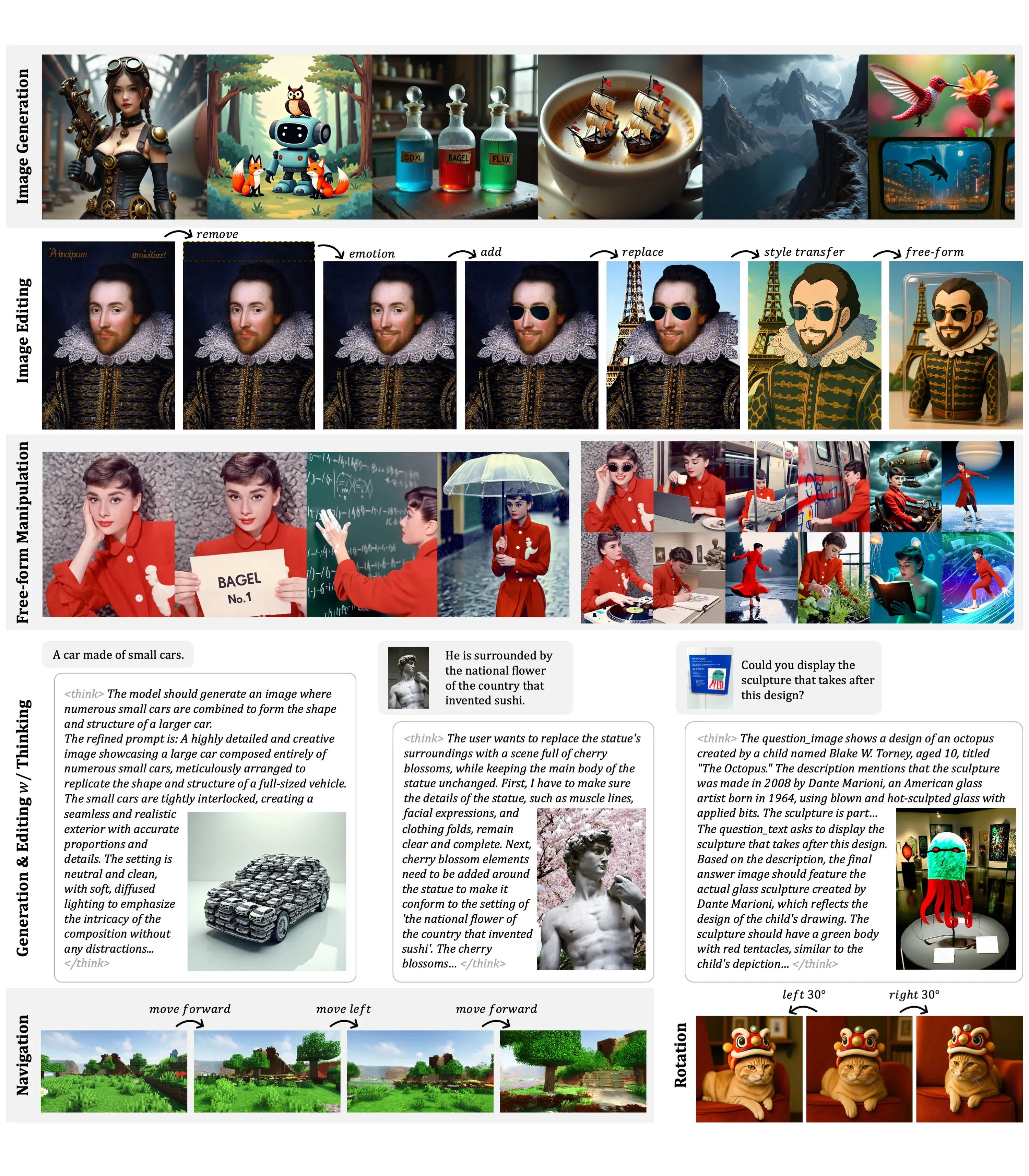

BAGEL集视觉理解、文生图、图像编辑于一体,在标准多模态理解基准测试中表现出色,优于现有顶级开源视觉语言模型如Qwen2.5-VL和InternVL-2.5。

在文本到图像生成质量上,BAGEL的表现可与专用生成器SD3相媲美。在经典图像编辑场景中,BAGEL展示了优于许多领先开源模型的定性结果。

BAGEL采用了混合变换器专家(MoT)架构,并使用两个独立编码器分别捕捉图像的像素级和语义级特征。模型遵循“下一个标记组预测”范式进行训练,预训练使用了来自语言、图像、视频和网络数据的数万亿个交错的多模态标记。

经过持续训练和监督微调,BAGEL展示了先进的上下文多模态能力,包括自由形式图像编辑、未来帧预测、三维操作和世界导航(“世界建模”任务)。

研究表明,结合变分自编码器(VAE)和视觉变换器(ViT)的特征显著提升了智能编辑能力。BAGEL以Apache 2.0许可证开源。

开源地址

https://huggingface.co/ByteDance-Seed/BAGEL-7B-MoT

https://github.com/ByteDance-Seed/Bagel

论文地址

https://arxiv.org/abs/2505.14683