Docker 在其年度 DockerCon 开发者大会主题演讲中宣布与 Neo4j、LangChain 和 Ollama 合作推出新的 GenAI Stack。该 GenAI Stack 简化了 AI/ML 集成,旨在帮助开发人员快速轻松地构建生成式 AI 应用程序,而无需搜索和配置各种技术。

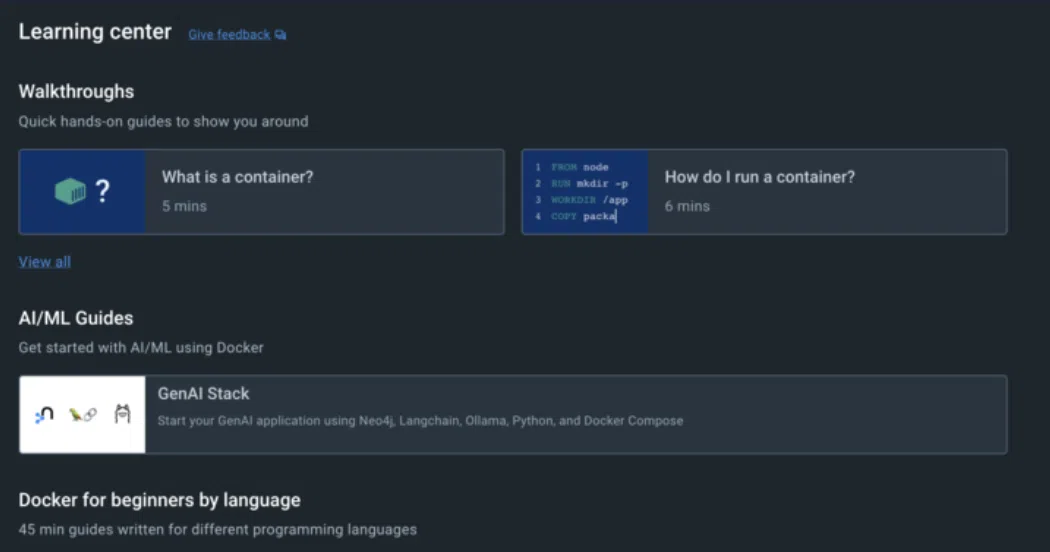

根据介绍,GenAI Stack 中包含的内容包括有:

- 预配置的 LLM:提供预配置的大语言模型 (LLM),例如 Llama2、GPT-3.5 和 GPT-4,以快速启动 AI 项目。

- Ollama 管理:Ollama 简化了开源 LLM 的本地管理,让你的 AI 开发过程更加顺畅。

- Neo4j 作为默认数据库:Neo4j 作为默认数据库,提供图形和原生向量搜索功能。这有助于揭示数据模式和关系,最终提高 AI/ML 模型的速度和准确性。Neo4j 还充当这些模型的长期存储器。

- Neo4j 知识图谱:Neo4j 知识图谱为 LLM 提供更精确的 GenAI 预测和结果。

- LangChain 编排:LangChain 促进了LLM、应用程序和数据库之间的通信,并提供了一个强大的向量索引。LangChain 是一个用于开发由 LLM 支持的应用程序的框架。其中包括 LangSmith,一种调试、测试、评估和监控 LLM 应用程序的新方法。

- 全面支持:提供了一系列有用的工具、代码模板、操作指南和 GenAI 最佳实践。

此外,该公司还通过抢先体验计划推出了一款新的生成式 AI 助手,名为 Docker AI。 Docker 首席执行官 Scott Johnston 表示,与 Copilot 或 Amazon CodeWhisperer 等其他代码生成助手相比,Docker AI 助手可以帮助开发人员定义应用程序的各个方面并排除故障。

"当开发人员编辑 Dockerfile 或 Docker Compose 文件、调试本地 docker build 或在本地运行测试时,Docker AI 会根据具体情况提供自动指导。