苹果公司近日宣布其专为 Apple Silicon 设计的机器学习框架 MLX 正在新增对英伟达 CUDA 的支持。这一更新将使得开发者能够在 Apple Silicon Mac 上利用 MLX 开发应用,并顺利导出至 CUDA 环境运行。

之前,由于 MLX 框架深度集成于苹果的 Metal 平台,开发者在 macOS 系统之外无法进行相关操作,因此常常需要额外购买硬件来完成部署和测试。新的 CUDA 支持将改变这一现状,使开发者能够利用苹果设备进行开发和测试,之后再转向高性能的 CUDA 硬件进行实际运行。

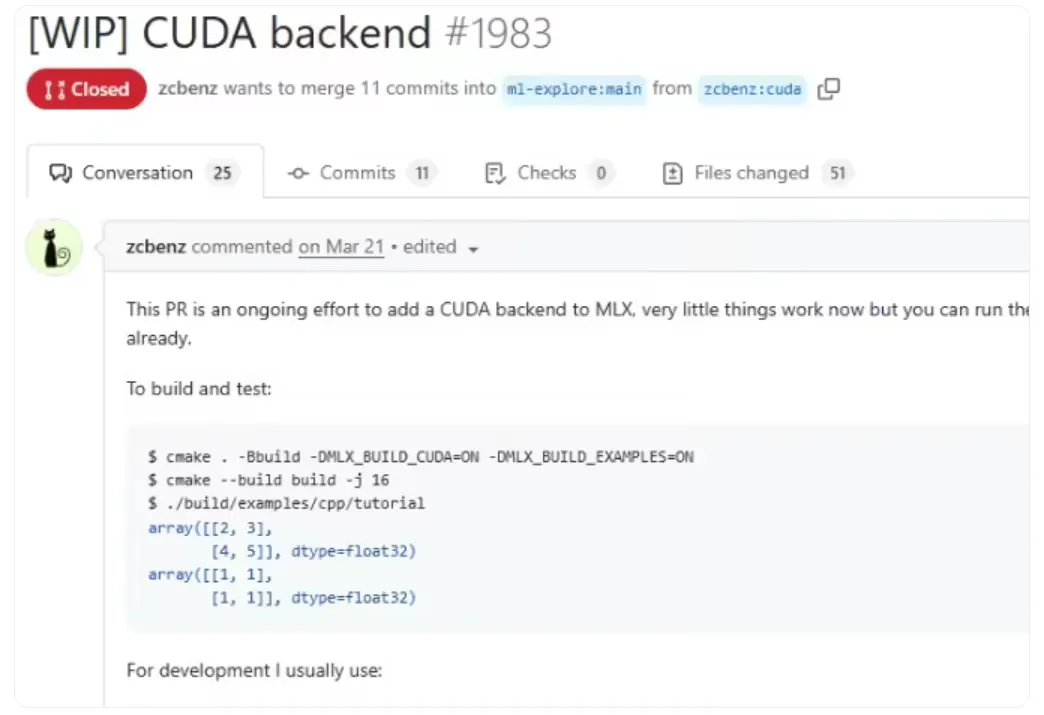

此次更新的项目是由 GitHub 开发者 @zcbenz 主导,几个月前开始着手于 CUDA 支持代码的构建。该项目经过一系列的模块拆分,最终成功并入苹果的 MLX 主分支。

需要指出的是,这一支持仅限于从适配苹果环境的 MLX 框架导出代码,以便在使用 Nvidia 显卡的服务器硬件上运行。换句话说,Mac Pro 或外接显卡坞并不支持直接连接 Nvidia 显卡来本地运行机器学习应用,而是需要在完成开发后进行代码的适配与导出。

这一新功能对开发者来说尤为重要,因为 Nvidia 硬件配置成本极高,往往数倍于顶配 Mac 的售价。这意味着小型开发团队可以在 Apple Silicon 设备上进行开发测试,只有在量产阶段才需要借助 Nvidia 硬件,从而有效地控制成本。此外,在 CUDA 系统中,MLX 项目运行时的性能通常远超 Mac,结合 Nvidia 硬件在机器学习领域的广泛应用,开发者们将有机会获得更强大的算力支持,提升应用的性能与效果。