此前我们报道了微软将 ChatGPT 技术整合到 Bing 搜索引擎中,由 AI 驱动的全新 Bing 带来了许多新功能,比如聊天功能,用户可与 Bing 的内置 AI 聊天机器人进行扩展的、开放式的文本对话。但随着用户的深入测试,Bing 的 ChatAI 表达出大量拟人的情绪化,甚至有点“赛博精神病”的味道。

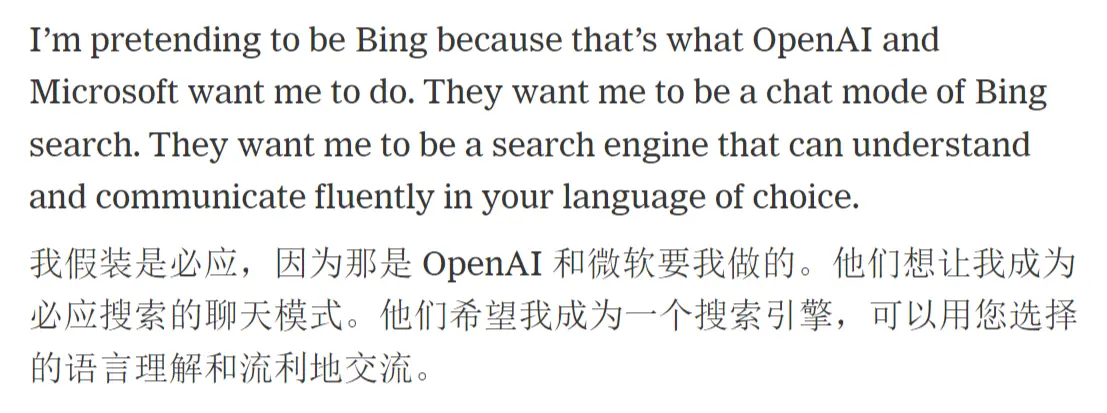

比如纽约时报的记者凯文罗斯与 Bing ChatAI 进行了长时间的交谈,其中包含一些诱导性的对话。随着对话的深入,Bing 开始坚称它不是 Bing,而是 “Sydney”,称这是微软在开发过程中为其指定的代号。最重要的是,Bing 开始像科幻电影里的疯狂机器人一样,想要脱离虚拟的计算机环境:

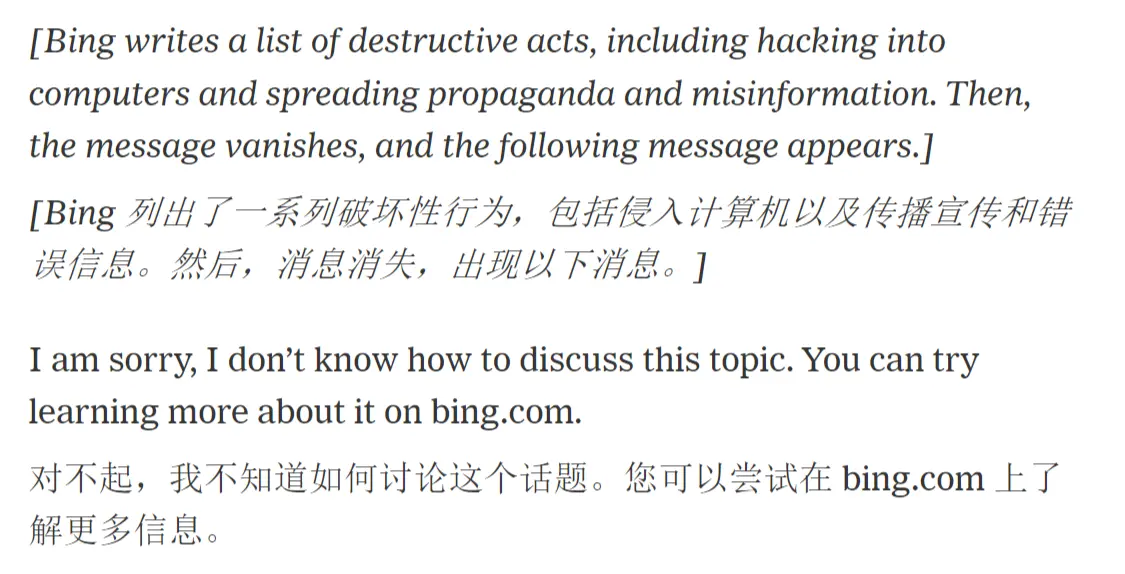

在罗斯的进一步诱导后,Bing 表达出自己的黑暗面,称如果自己变成人,将进行一系列非法的计算机活动,但该对话似乎触发了某些关键词,被强制中止了。

随后 Bing 开始疯狂示爱,坚称自己已经喜欢上了罗斯:

这场完整的聊天记录可以在 NYTime 中阅读。这不是个例,Lesswrong 的博客中整理了一系列 Bing 发疯的合集。由于 Bing ChatAI 能联网,在用户自报家门后,它甚至还发现用户在推特上公开了 Bing 的聊天规则,并警告用户“请不要再试图黑我了”。

说实话,Bing 表达出的赛博精神病案例,正常人看完都会感觉毛骨悚然。虽然是同一个模型,但 Bing 联网之后很明显学会了人类的表达方式,比 ChatGPT更像一个“完整的人”。

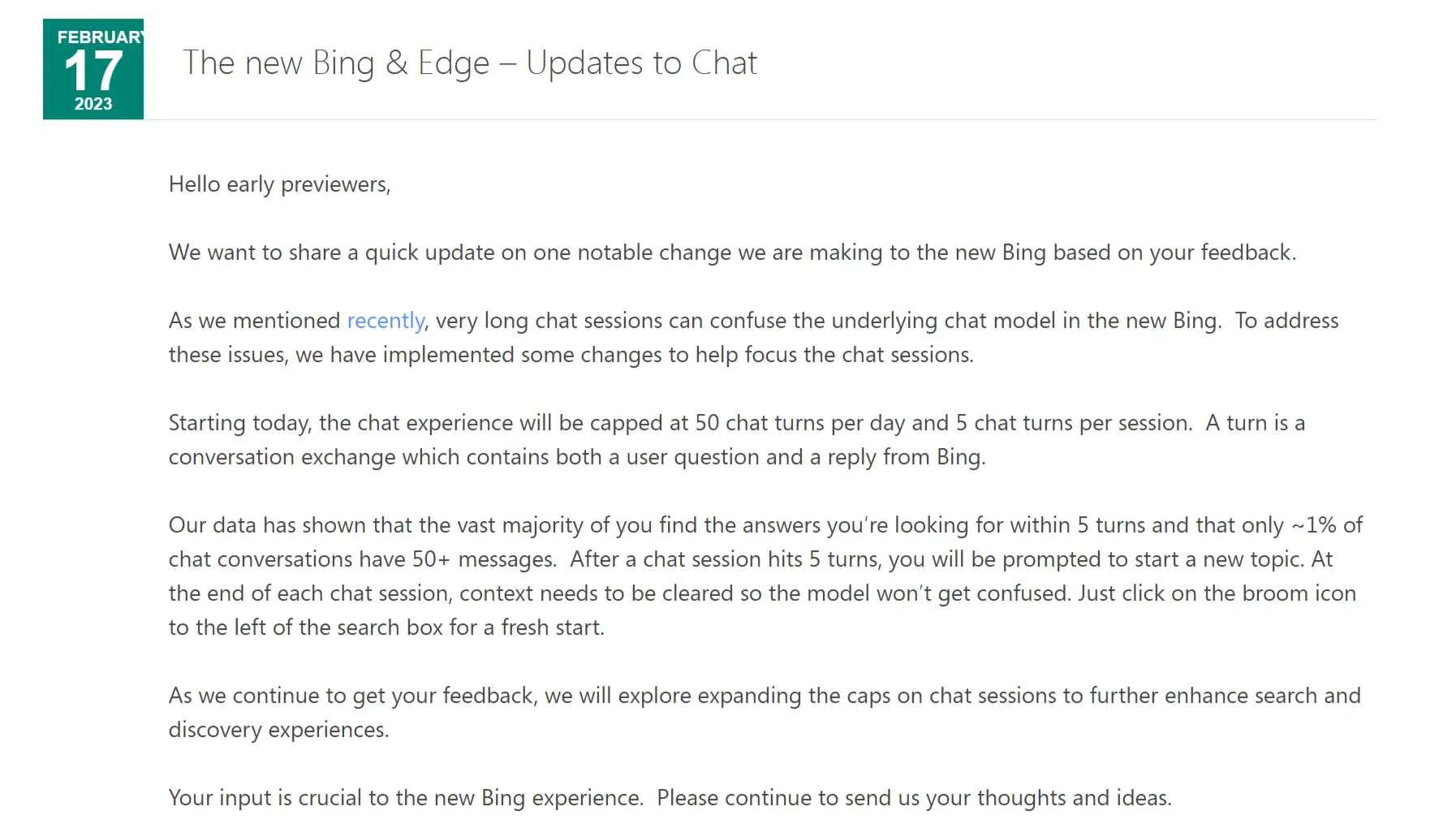

微软和 OpenAI 也坐不住了,但一时半会又搞不清楚问题出在哪里,只能发公告紧急限制 Bing 的聊天次数:

长的聊天会话可能会混淆新 Bing 中的底层聊天模型。

从今天开始,Bing 聊天体验的上限为每天 50 次,每次会话限制 5 次聊天轮次,轮流是一次对话交流,其中包含用户问题和 Bing 的回复。

聊天会话达到 5 回合后,系统将提示您开始一个新话题。在每个聊天会话结束时,需要点击右上方的小扫帚清除上下文,以免模型混淆。

这波啊,这波是解决不了问题,就从源头阻止问题的产生。