写 AI 应用,你总不能就指望大模型直出的效果吧,很多必要的时候,需要“通过外部策略”的方式去影响大模型处理资料的逻辑,检索增强生成技术 RAG 是这种路数,而 RAG 中,Embedding 和 Reranker 又是重中之重的环节,当前这两个环节也都有专门模型化范式来接入,并且已成为高效构建智能问答、知识检索、推荐系统等应用的核心组件。

智能问答:通过高精度的 Embedding 建立问答对检索索引,结合 Reranker 精细排序,显著提升答案的相关性与准确率。

知识库检索:在海量文档中精准定位用户意图,支持多轮对话和上下文关联检索。

推荐系统:基于用户历史行为与商品描述生成向量表示,实现个性化推荐、相似内容召回。

舆情监测:快速将海量文本转为向量,通过聚类与分类算法进行主题发现与情感分析。

这些都是典型的需要 Embedding 与 Reranker 给力的场景。

这过程中,“把文字变成数字”与“对检索结果精修”是两大核心环节。下面以通俗的方式,分两块为你说明 Embedding 和 Reranker 的原理与价值。

Embedding:把语义“压缩”成向量

想象你在把一本书里的每句话都翻译成一长串数字,这串数字既要能表达句子的中心意思,又要在空间里与含义相近的句子靠得更近。Embedding 模型,就是完成这件“翻译”工作的机器。

多层语义提取

Embedding 模型内部运用了多层 Transformer 编码器。第一层关注词与词之间的基本搭配(如“苹果”与“果汁”关系);中间层捕捉句子结构(比如主谓宾),最后几层则把整句话和上下文联系起来,形成一个高维向量。在 Qwen3‑Embedding‑8B 中,这个向量高达 4096 维,让模型能够在更广的维度上区分细微差异。

对比学习让向量更“聪明”

训练时,模型不仅看成对的问答或同义句怎么对应,更会把数千万甚至上亿条不相关的句子拉远。这样,真正相似的句子在向量空间里互相靠近,不相干的句子被推得更远,检索时才不会把“苹果手机电池续航”误当成“香蕉营养价值”。

动静结合的量化策略

向量越大,存储和检索压力越大。动态量化技术能让模型在运行时自动决定哪些维度可以用更低精度来存(节省空间),哪些维度要保持高精度(保证关键语义不丢失)。在实际部署中,这让检索速度实现了“百毫秒级”响应,同时节省了约 60–70% 的存储。

Reranker:给检索结果“打分”再排序

Embedding 检索出来的是一个粗略的“候选集”,真正要交给用户之前,还需要一位“品质检验师”——Reranker,将这些候选答案再打一遍分、排个序,让最优答案排在最前面。

深度交互,跳出双塔局限

传统双塔结构(query 和 document 分别编码)虽然高效,但只在编码后进行一次简单匹配,会错失一些深度关联。我们的 Reranker 在两侧编码后,还会引入多轮交互注意力——就好像让问题和答案反复“对话”,捕捉细节差异,才能判断“哪句话更贴近用户真实意图”。

实时反馈持续进化

当用户点击某个答案或给出负面评价时,这些行为会被立即反馈到在线增量学习系统中。Reranker 会在后台快速微调自身参数,就像运动员不断根据比赛录像调整战术,保证随着业务热点变化,排序效果始终领先。

多目标优化兼顾公平与准确

除了相关性打分外,模型还联合了分类(这是不是好答案?)、回归(该答案得分应该是多少?)和对比损失(同类答案之间应该怎么排)三个目标共同训练,确保排序既精准又稳定,不会因为单一指标过拟合而出现极端情况。

总的来说,Embedding 负责将文本“量化”到高维空间,为检索打下基础;Reranker 则在此基础上“打磨”结果,确保输给用户的是最精炼、最相关的答案。

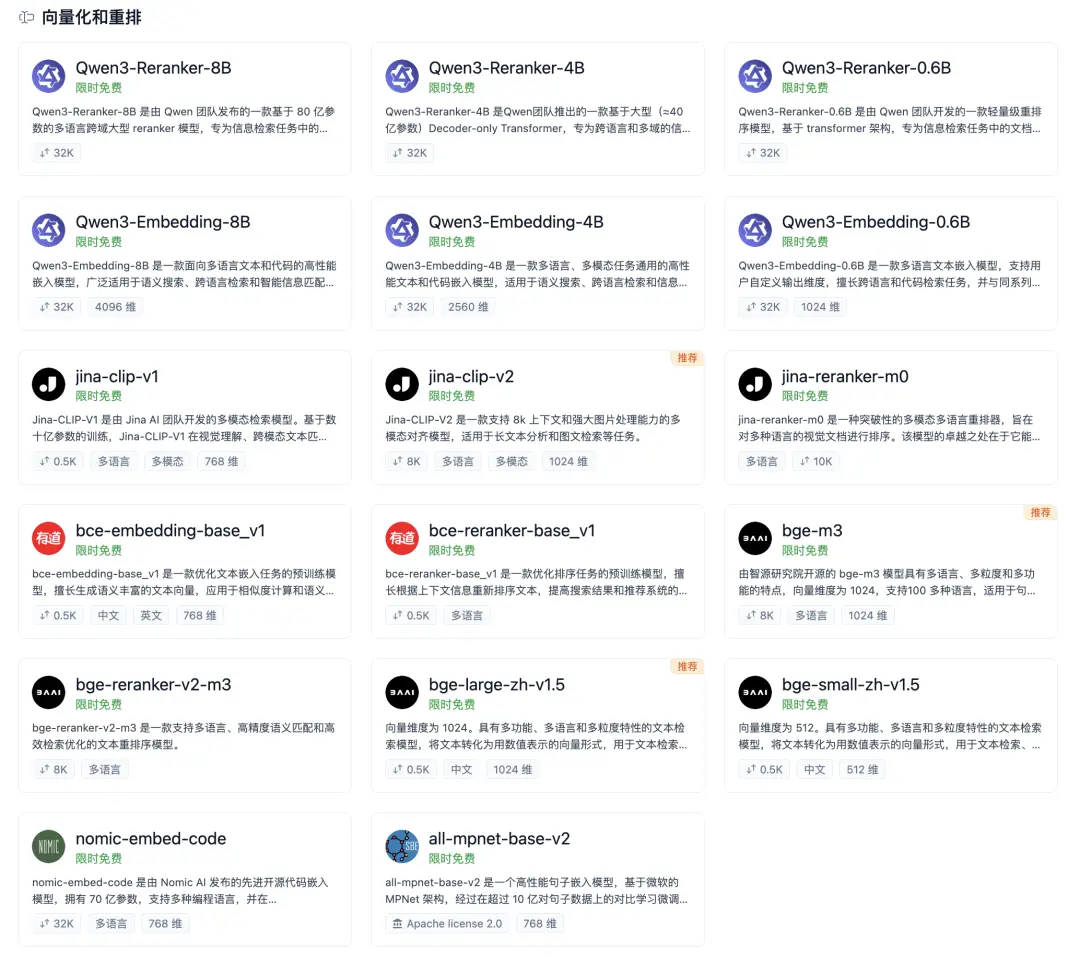

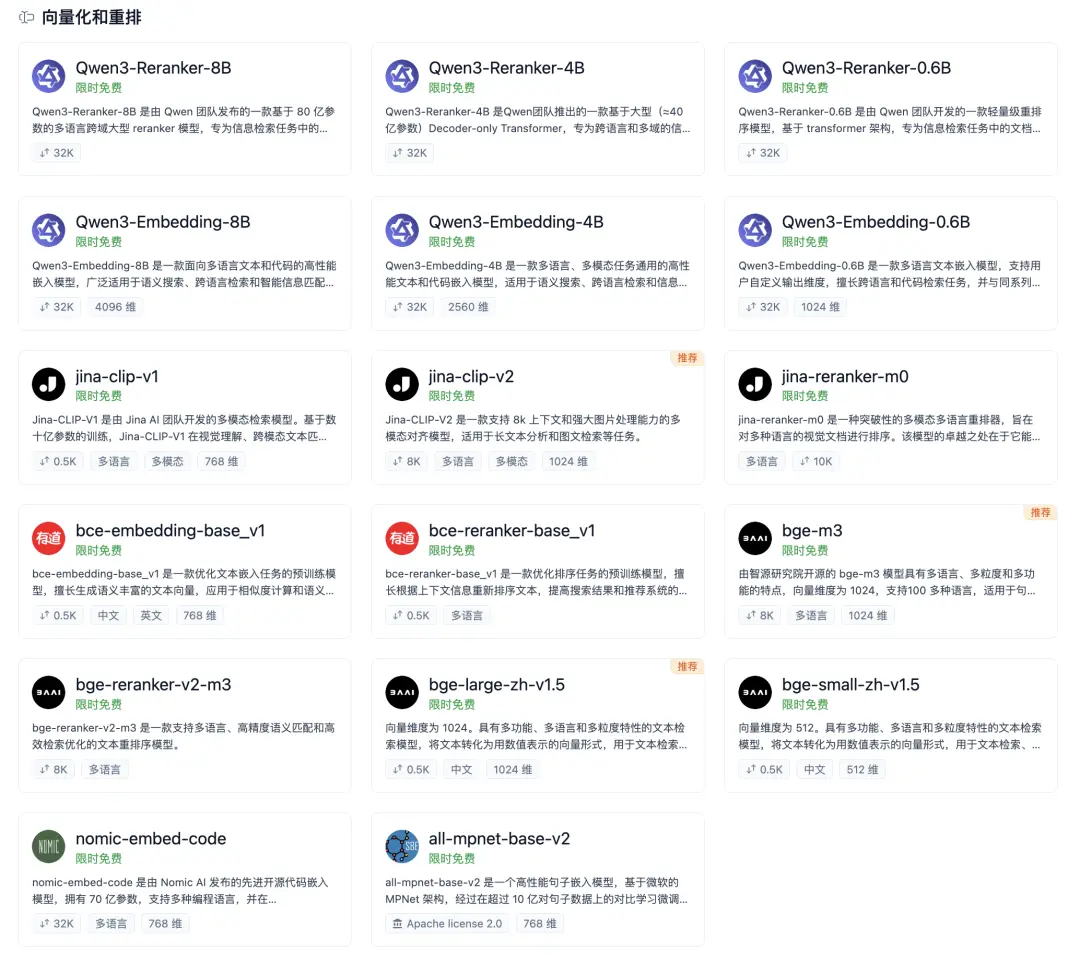

为了让更多开发者和企业能够零门槛体验最前沿的 AI 能力,模力方舟携手国产 GPU 厂商,重磅宣布——已部署的 17 个 Embedding 和 Reranker 模型,全量免费使用!

还有更多的免费模型选择,尽在模力方舟之模型广场:https://ai.gitee.com/serverless-api

好东西一起分享之,图片拿去转吧。