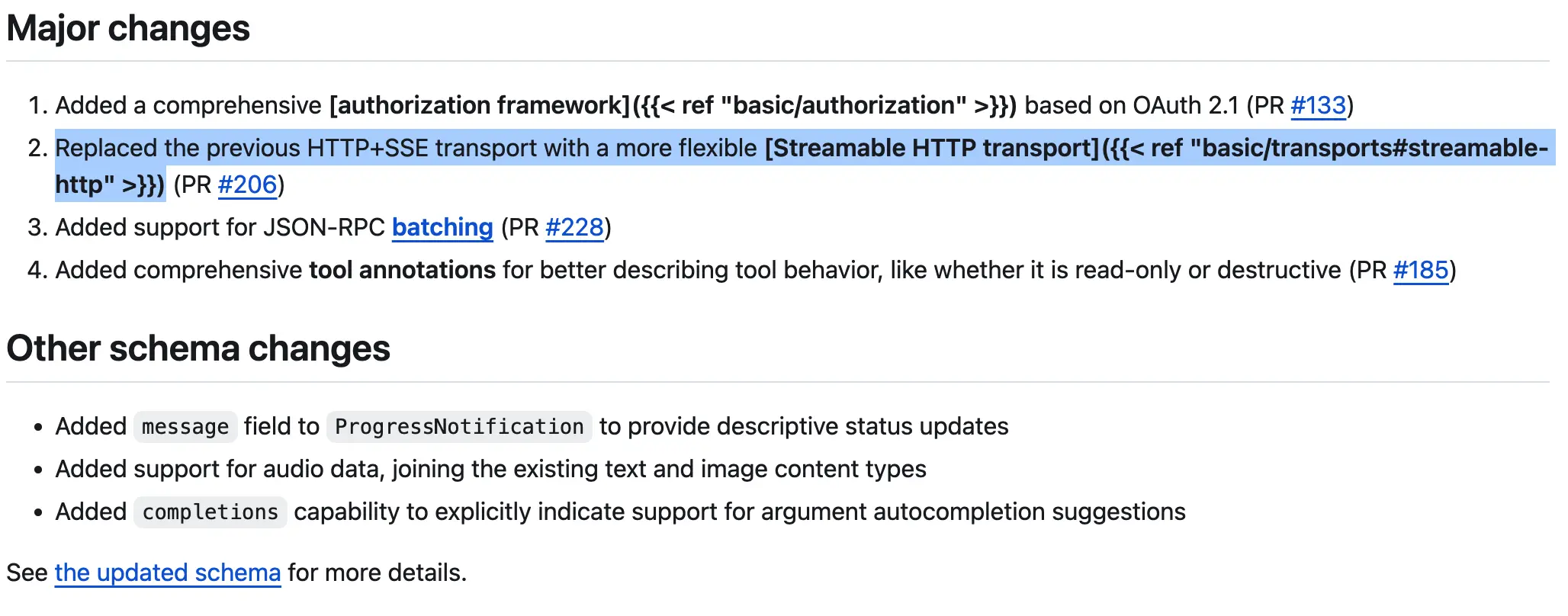

开源模型上下文协议 MCP 规范今天发布了新版本,一些主要变化:

- 基于 OAuth 2.1 的身份验证框架

- 用 Streamable HTTP 传输取代了以前的 HTTP+SSE 传输

- 支持 JSON-RPC 批处理

- 工具注释可以更好地描述工具行为

详情查看 https://github.com/modelcontextprotocol/specification/tree/main/docs/specification/2025-03-26

Streamable HTTP 改变了 MCP 的数据传输方式,让协议变得:

-

更灵活(支持流式传输,但不强制)

-

更易用(支持无状态服务器)

-

更兼容(适用于标准 HTTP 基础设施)

💡 简单比喻: 原来的 MCP 传输方式就像是你和客服通话时必须一直保持在线(SSE 需要长连接),而新的方式更像是你随时可以发消息,然后等回复(普通 HTTP 请求,但可以流式传输)。

主要变更

-

移除 /sse 端点

- 服务器不再单独维护 SSE(Server-Sent Events)端点。

-

所有客户端 → 服务器的消息都通过 /message 端点

- 任何数据传输都通过 /message 进行,不再依赖 /sse。

-

服务器可以选择升级请求为 SSE

- 服务器可以根据需要动态升级 HTTP 请求为 SSE 流,用于发送通知或请求。

-

客户端通过 Header 提供 Mcp-Session-Id

- 服务器可选是否需要存储 Session 信息,但客户端始终发送 Mcp-Session-Id 头部信息。

-

支持无状态(Stateless)服务器

- 服务器可选择完全无状态运行,不再需要维持长期连接。